一般公開「小池邦人のCarbon視点でiPhone探求」

(MOSADeN Onlineでは、掲載日から180日を経過した記事を一般公開しています。)- 顔認識とCore Imageフィルタのコラボ(2013/10/29:掲載)

- CGColorRefではパタン描画も可能です(2013/08/23:掲載)

- Core Imageのトランジション用フィルタ(2013/06/26:掲載)

- ビューコントローラの入れ子状態(2013/04/22:掲載)

- iOS 6でEAGLViewをスクリーンキャプチャする(2013/02/17:掲載)

- Core Imageでビデオ映像にフィルタ処理(2012/12/17:掲載)

- ビデオ映像をOpenGLテクスチャとして使う(2012/10/27:掲載)

- キーフレームアニメーションの実行(2012/09/15:掲載)

- 明示的アニメーションで変化を拾う(2012/08/27:掲載)

- お手軽なUIViewアニメーションを使う(2012/05/23:掲載)

- 暗黙的アニメーションは忘れましょう!(2012/04/26:掲載)

- 暗黙的と明白的アニメーション(2012/04/13:掲載)

- UIViewに割り当てられたCALayer(2012/03/27:掲載)

- CALayerのサブクラスを調べる(2012/03/21:掲載)

- CIImage発、CGImageRef経由、UIImage行き(2012/02/27:掲載)

- こんな機能もあったのか!(2012/02/16:掲載)

- もっとビルトイン・フィルタを!(2012/01/30:掲載)

- くっきり、すっきり、名称変更!(2012/01/12:掲載)

- 果敢にローカライズをしましょう!(2011/12/22:掲載)

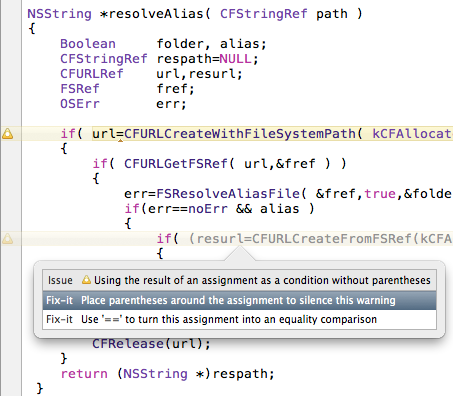

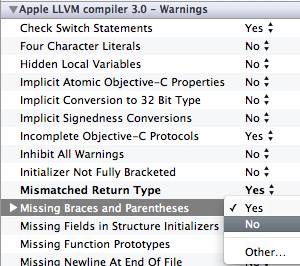

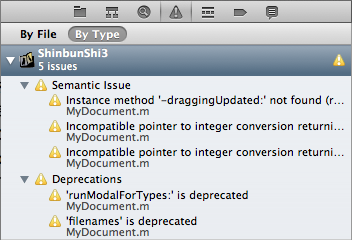

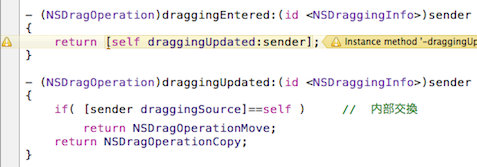

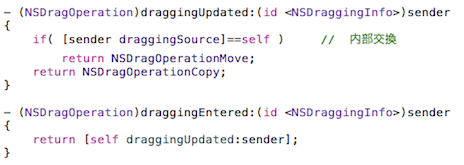

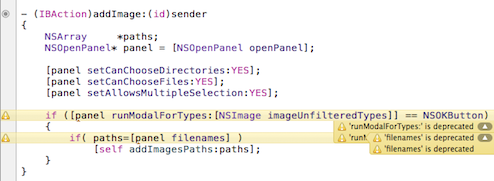

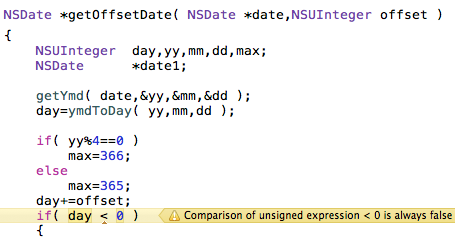

- すべてのイエローカードを解消する(2011/11/29:掲載)

- イエローカードを解消する前に(2011/11/17:掲載)

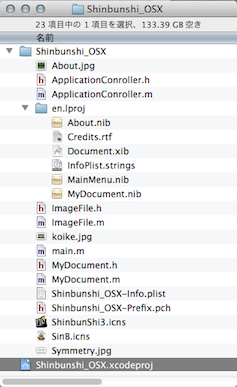

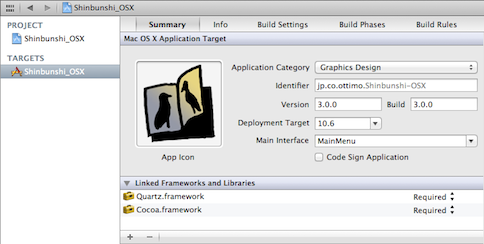

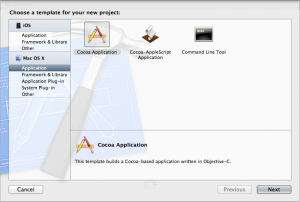

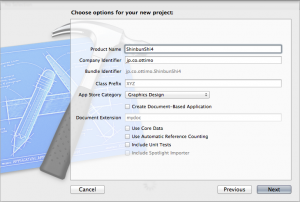

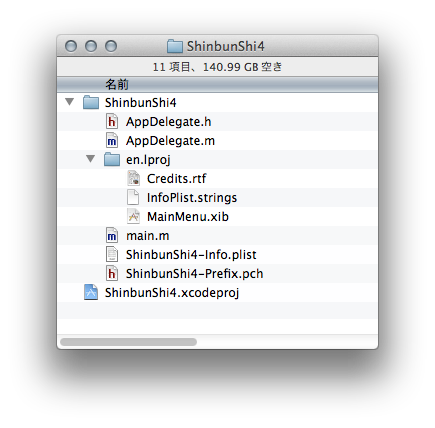

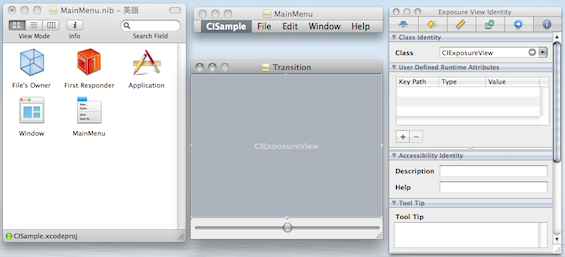

- まずは新規プロジェクト作成から(2011/10/26:掲載)

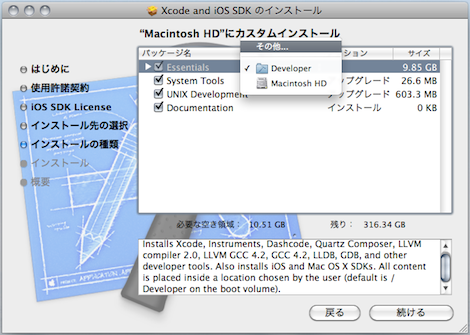

- Xcode 4の時代がやって来た(2011/09/15:掲載)

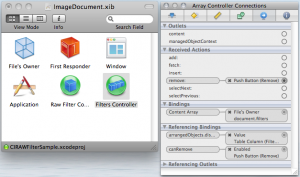

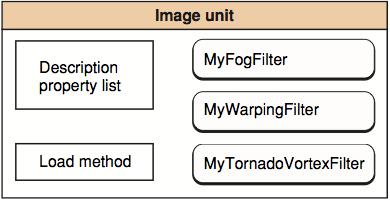

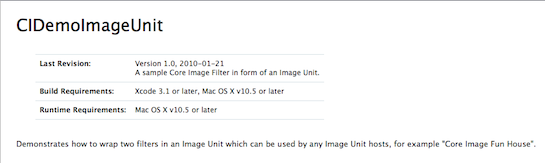

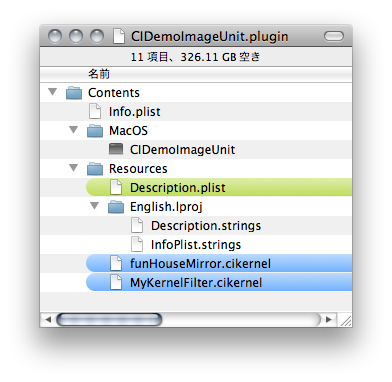

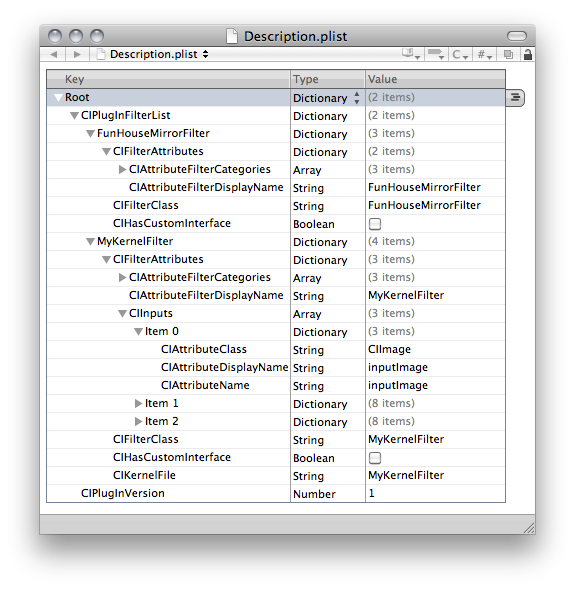

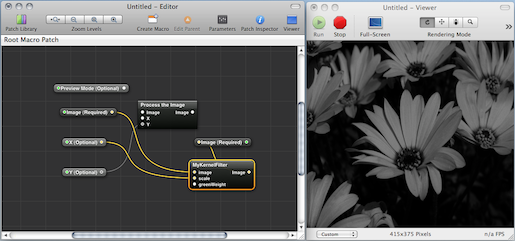

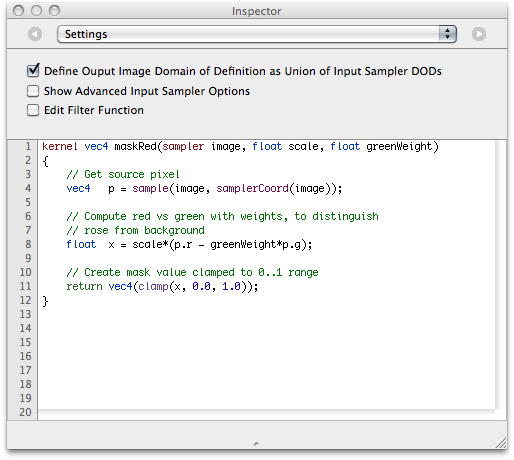

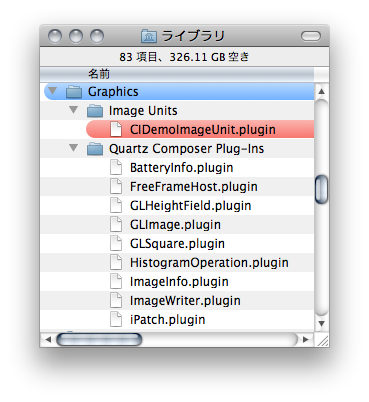

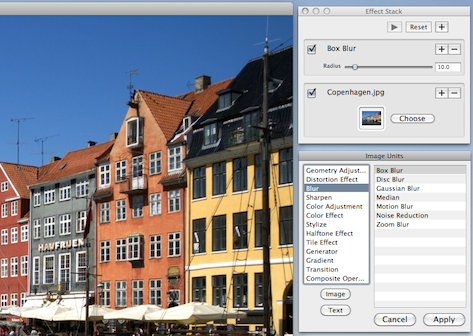

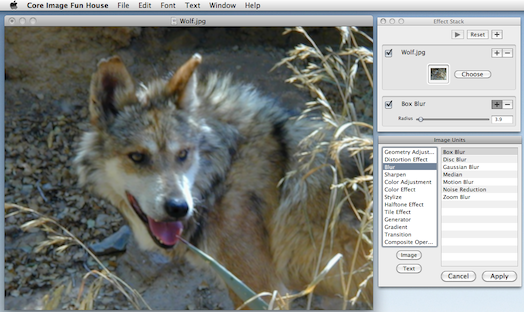

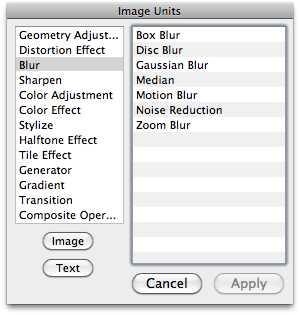

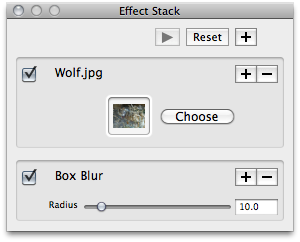

- Image Unitを開発するには(2011/09/03:掲載)

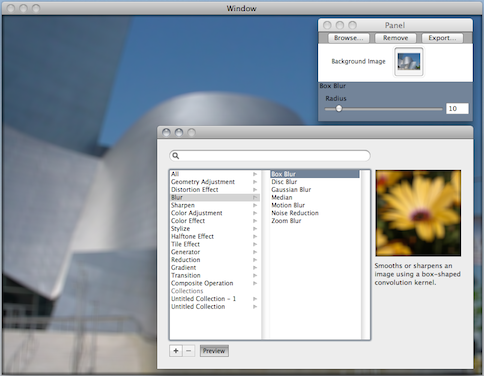

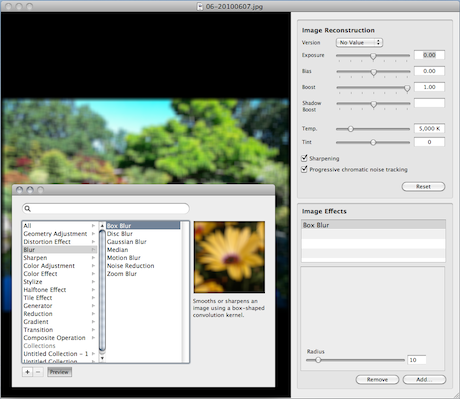

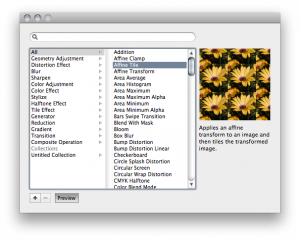

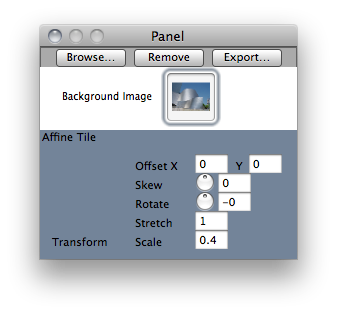

- Filter Browserをオープンする(2011/08/13:掲載)

- トランジション用フィルタを使う(2011/07/20:掲載)

- フィルタ処理で消費されるメモリ(2011/07/04:掲載)

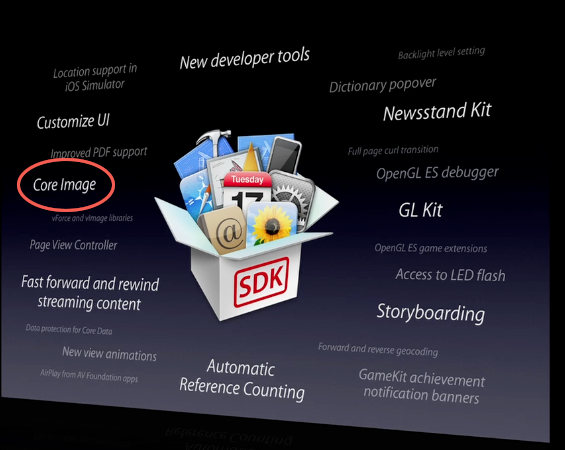

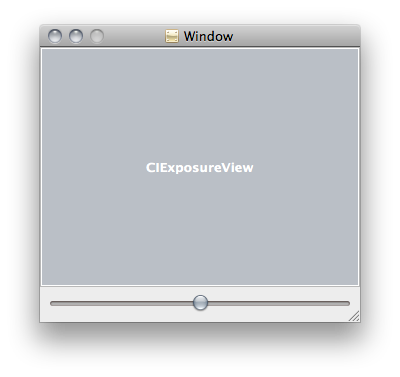

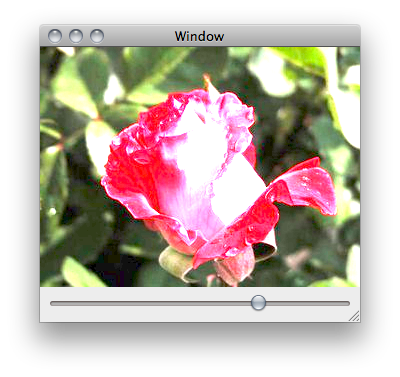

- Core ImageがiOSにやってきた!(2011/06/16:掲載)

- Core Imageとは何ぞや?(2011/06/02:掲載)

- 残り物には福があるのか?(2011/05/21:掲載)

-

顔認識とCore Imageフィルタのコラボ

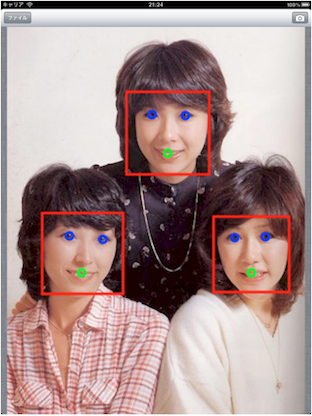

この記事は、2013年10月29日に掲載されました。以前に単独機能として紹介しましたが、「顔認識」は、OS X 10.7(Lion)とiOS 5からCore Imageに新しく追加された機能です。写真(画像)から人間の顔を抽出し、その顔の輪郭、目の位置、口の位置などを座標値として得る事ができます。この機能を使うのは簡単で、適切なオプション(NSDictonary)を設定してから、次のクラスメソッドでCIDetectorクラスのインスタンスを作成しておきます。

(CIDetector *)detectorOfType:(NSString*)type context:(CIContext *)context options:(NSDictionary *)options顔認識は、CIDetectorAccuracyキーで「認識率を優先するのか?」「認識処理速度を優先するのか?」を選択できます。次の例は、CIDetectorAccuracyHigh値を代入して認識率を上げることを優先しています。現バージョンがサポートしている顔認識のタイプはCIDetectorTypeFace(人間の顔)だけです。残念ながら犬や猫はダメですね(笑)。

NSDictionary *options; // オプション値はCIDetectorAccuracyHighでキーはCIDetectorAccuracy options=[[NSDictionary alloc] initWithObjectsAndKeys: CIDetectorAccuracyHigh,CIDetectorAccuracy,nil]; faceDetector=[[CIDetector detectorOfType:CIDetectorTypeFace context:nil options:options]retain]; // CIDetectorインスタンス作成顔認識処理の実行は次のメソッドで行います。結果はCIFeatureオブジェクトの配列で返されます。写真に複数の人が写っていても、その人数分だけ認識されます(人数に限界があるかどうかは未確認)。ここで渡すオプションは画像の回転情報です。

- (NSArray *)featuresInImage:(CIImage *)image options:(NSDictionary *)optionsCIFeatureクラスには、顔の枠を示すboundsプロパティ(CGRect)や、両目の位置を示すleftEyePositionとrightEyePositionプロパティ(CGPoint)、そして口の位置を示すmouthPositionプロパティ(CGPoint)が保存されています。顔認識に成功した場合には、これらのプロパティを参照することで各エリアに対して特定の処理を実行できます。今回のサンプルでは、写真で認識した顔をモザイク処理します。このCore Imageによるフィルタ処理では、認識されたすべての顔をモザイク処理の対象とします。

まずは顔認識の準備と必要とされる画像やフィルタの準備です。準備した画像やフィルタなどを保存しておくインスタンス変数は次の通りです。

IBOutlet UIImageView *imageView; // 画像表示用 CIContext *ciContext; // 描画用コンテキスト CIFilter *blendFilter; // 合成用フィルタ CIImage *sourceImage; // ソース画像 CIImage *maskImage; // マスク画像 NSMutableArray *centerArray; // 顔認識の位置の配列 CGFloat inputValue; // ボザイクのスケールsetupFilterメソッドでは、対象となるソース画像(sourceImage)を呼び込み、自作のdoFaceDetectメソッドで顔認識を実行します。もし認識された顔があれば(複数でもOK)centerArrayに顔の中心座標が保存されて戻ります。そしてCIRadialGradientフィルタにより人数分だけ顔の位置に円のグラデーションを発生させてから、CISourceOverCompositingフィルタで順次合成していきます。そして、最終的にソース画像全体に対応するマスク画像(maskImage)を作成します。

- (void)setupFilter // フィルタの準備を行う { CIFilter *gradientFilter; NSURL *url; if( url=[[NSBundle mainBundle] URLForResource:@"Image" withExtension:@"jpg"] ) { if( sourceImage=[CIImage imageWithContentsOfURL:url] ) // 画像を読み込む { if( [self doFaceDetect]==YES ) // 顔認識を実行する { inputValue=10.0; // 初期モザイクスケール ciContext=[CIContext contextWithOptions:nil]; // マスクとの合成用フィルタで後からdoFilterで使う blendFilter=[CIFilter filterWithName:@"CIBlendWithMask" keysAndValues:@"inputBackgroundImage",sourceImage,nil]; // 顔の回りに円のグラデーションを発生させるため gradientFilter=[CIFilter filterWithName:@"CIRadialGradient" keysAndValues: @"inputRadius0",[NSNumber numberWithFloat:40.0], @"inputRadius1",[NSNumber numberWithFloat:80.0], @"inputColor0",[CIColor colorWithRed:1.0 green:1.0 blue:1.0 alpha:1.0], @"inputColor1",[CIColor colorWithRed:1.0 green:1.0 blue:1.0 alpha:0.0],nil]; // 認識された顔の回りに円のグラデーションを発生さ合成していく for( CIVector *center in centerArray ) { [gradientFilter setValue:center forKey: @"inputCenter"]; if( ! maskImage ) maskImage=gradientFilter.outputImage; else { maskImage=[CIFilter filterWithName:@"CISourceOverCompositing" keysAndValues: @"inputImage",gradientFilter.outputImage, @"inputBackgroundImage",maskImage,nil].outputImage; } } } } } }こちらが顔認識を行っているdoFaceDetectメソッドです。 読み込み済みのソース画像(sourceImage)を認識の対象にし、認識された人数分の顔の中心座標を配列(centerArray)に保存します。

- (BOOL)doFaceDetect // 顔認識を実行する { CIDetector *detector; NSArray *faceArray; CGFloat cx,cy; if( detector=[CIDetector detectorOfType:CIDetectorTypeFace context:nil options:nil] ) { faceArray=[detector featuresInImage:sourceImage options:nil]; // 顔認識を実行 if( [faceArray count] ) // 顔認識された { centerArray=[NSMutableArray array]; for( CIFeature *face in faceArray ) // 認識した分だけ中心座標を配列へ保存する { cx=face.bounds.origin.x+face.bounds.size.width/2.0; cy=face.bounds.origin.y+face.bounds.size.height/2.0; [centerArray addObject:[CIVector vectorWithX:cx Y:cy]]; } return YES; } } return NO; }最後が完成した画像を表示させるdoFilterメソッドです。inputValueにモザイクスケール(タイルの大きさ)の値を入れてこのソッドを呼びだすと、CIBlendWithMaskフィルタを使いsetupFilterで作成しておいたマスク画像でソース画像を抜き、それとCIPixellateフィルタで作成したておいたモザイク画像を合成してからUIImageViewに表示します。

- (void)doFilter // フィルタ処理を実行する { CIFilter *pixelFilter; CGImageRef cgimage; CGRect drt; if( ciContext && blendFilter ) { // 画像全体をモザイクにするため(モザイクスケールはinputValueで可変) pixelFilter=[CIFilter filterWithName:@"CIPixellate" keysAndValues:@"inputImage",sourceImage, @"inputScale",[NSNumber numberWithFloat:inputValue],nil]; // オリジナル画像とモザイク画像をマスクで抜いた画像の合成 [blendFilter setValue:pixelFilter.outputImage forKey: @"inputImage"]; [blendFilter setValue:maskImage forKey: @"inputMaskImage"]; drt=[sourceImage extent]; cgimage=[ciContext createCGImage:blendFilter.outputImage fromRect:drt]; imageView.image=[UIImage imageWithCGImage:cgimage]; // 結果を表示する CGImageRelease( cgimage ); } }「Mac OS XとiOS 行ったり来たり」というタイトルで長い間連載してきましたが、OS XとiOSの立ち位置も微妙に変化してきています。将来的には、何か大きな動きがあるかもしれません(統合?)。そんな訳で、本連載はここまでとし、可能であれば、また別テーマで新連載を始められたらと思います。長い間のご愛読ありがとうございました!

-

CGColorRefではパタン描画も可能です

この記事は、2013年08月23日に掲載されました。通常iOSアプリでのカラー操作にはUIColorオブジェクトを利用します。UIColorは、RGB、HSB、グレイスケールの値を使いカラー値を指定できる簡易メ ソッドを備えています。またデフォルトとして用意されているカラー値を得るには、以下のファクトリーメソッドを用いると便利です。

+ (UIColor *)blackColor; // 0.0 ブラック + (UIColor *)darkGrayColor; // 0.333 暗いグレー + (UIColor *)lightGrayColor; // 0.667 明るいグレー + (UIColor *)whiteColor; // 1.0 ホワイト + (UIColor *)grayColor; // 0.5 グレー + (UIColor *)redColor; // 1.0, 0.0, 0.0 レッド + (UIColor *)greenColor; // 0.0, 1.0, 0.0 グリーン + (UIColor *)blueColor; // 0.0, 0.0, 1.0 ブルー + (UIColor *)cyanColor; // 0.0, 1.0, 1.0 シアン + (UIColor *)yellowColor; // 1.0, 1.0, 0.0 イエロー + (UIColor *)magentaColor; // 1.0, 0.0, 1.0 マゼンタ + (UIColor *)orangeColor; // 1.0, 0.5, 0.0 オレンジ + (UIColor *)purpleColor; // 0.5, 0.0, 0.5 パープル + (UIColor *)brownColor; // 0.6, 0.4, 0.2 ブラウン + (UIColor *)clearColor; // 0.0 white, 0.0 クリア例としてRGB値を代入して使うなら次のメソッドを利用します。

+ (UIColor *)colorWithRed:(CGFloat)red green:(CGFloat)green blue:(CGFloat)blue alpha:(CGFloat)alpha;実はこうしたメソッド以外にも、ヘッダファイルのUIInterface.hには有用なUIColorのファクトリーメソッドが定義されています。これにより、iOS自身がグラフィックユーザインターフェース(GUI)を描画する時に用いているデフォルトのカラー情報を得ることが可能です。これは自身のGUIのカラーをシステム側と合わせたい場合などに有効です。

+ (UIColor *)lightTextColor; // 背景が暗いグレーの時 + (UIColor *)darkTextColor; // 背景が明るいグレーの時 + (UIColor *)groupTableViewBackgroundColor; // テーブルビュー背景色 + (UIColor *)viewFlipsideBackgroundColor; // ビューフリップの背景色 + (UIColor *)scrollViewTexturedBackgroundColor; // スクロールビュー背景色例えば自分のビューの背景としてスクロールビュー(UIScrollView)でのコンテンツ表示の背景パタンを使いたい時には、上記のscrollViewTexturedBackgroundColorクラスメソッドを用います。すると以下の様なパタン画像が描画されます(iPadの場合)。

myView.backgroundColor=[UIColor scrollViewTexturedBackgroundColor];UIViewのパタン背景はXcode 4.6のInterface Builder機能からも設定可能です。

ここで不思議なのは「UIColorでパタン画像を取り扱うことが可能なのか?」という点です。直接にはそうしたメソッドは用意されていませんが、Core GraphicsのCGColorRefのCGColorCreateWithPattern()ルーチンを使うと、カラーをパタン画像として登録できます。こうして作成したCGColorRefをUIColorのクラスメソッドであるColorWithCGColor:でUIColorに変換してUIViewのbackgroundColorプロパティにセットすれば、ビューの背景に利用できるわけです。

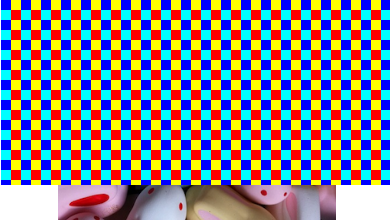

- (CGPatternRef)getPattern // 余白付きパタン(CGPatternRef)の作成 { CGPatternCallbacks callbacks={ 0,&drawPatternImage,NULL }; // コールバックルーチン CGPatternRef pattern; CGAffineTransform matrix; CGRect drt; drt=CGRectMake( 0,0,18,18 ); // パターン表示矩形(余白がある) matrix=CGAffineTransformMakeScale( 2.0,2.0 ); // 表示スケールを2倍に // コールバックルーチンや変換行列をセットしパターン作成 pattern=CGPatternCreate( NULL,drt,matrix,18,18, kCGPatternTilingConstantSpacing,true,&callbacks ); return pattern; } void drawPatternImage( void *info,CGContextRef ctx ) // 多色矩形パタン描画コールバック { CGRect prt1,prt2,prt3,prt4; prt1=CGRectMake( 0.0,0.0,5.0,5.0 ); // 縦横5.0の矩形 prt2=CGRectMake( 5.0,5.0,5.0,5.0 ); prt3=CGRectMake( 0.0,5.0,5.0,5.0 ); prt4=CGRectMake( 5.0,0.0,5.0,5.0 ); CGContextSetRGBFillColor( ctx,0.0,0.0,1.0,1.0 ); // 青色矩形 CGContextFillRect( ctx,prt1 ); CGContextSetRGBFillColor( ctx,1.0,0.0,0.0,1.0 ); // 赤色矩形 CGContextFillRect( ctx,prt2 ); CGContextSetRGBFillColor( ctx,0.0,1.0,1.0,1.0 ); // シアン矩形 CGContextFillRect( ctx,prt3 ); CGContextSetRGBFillColor( ctx,1.0,1.0,0.0,1.0 ); // 黄色矩形 CGContextFillRect( ctx,prt4) ; } - (IBAction)colorPattern // UIViewの背景としてパタン描画 { CGFloat alpha=1.0; CGPatternRef pattern; CGColorSpaceRef spece; CGColorRef color; pattern=[self getPattern]; // パタン(CGPatternRef)作成 spece=CGColorSpaceCreatePattern( NULL ); color=CGColorCreateWithPattern( spece,pattern,&alpha ); // パタンのCGColorRef作成 CGColorSpaceRelease( spece ); CGPatternRelease( pattern ); myView.backgroundColor=[UIColor colorWithCGColor:color]; // UIViewの背景カラー設定 }ところが、この方法でUIVIewの背景を設定すると、何故だかビューの矩形領域の背景が黒でクリアされてからパタン描画がなされることが分かります。

そこでUIVIewでなくCALayer(レイヤ)のbackgroundColorプロパティに直接CGColorRefをセットしてしまえば、矩形領域の黒によるクリアは行われません。- (IBAction)colorPattern // CALayerの背景としてパタン描画 { CGFloat alpha=1.0; CGPatternRef pattern; CGColorSpaceRef spece; CGColorRef color; pattern=[self getPattern]; // パタン(CGPatternRef)作成 spece=CGColorSpaceCreatePattern( NULL ); color=CGColorCreateWithPattern( spece,pattern,&alpha ); // パタンのCGColorRef作成 CGColorSpaceRelease( spece ); CGPatternRelease( pattern ); myView.layer.backgroundColor=color; // UIViewのCALayerの背景カラーを設定 }

UIViewでも各パタン画像を展開する場合の余白をゼロにすれば黒クリアの問題は影響ありません。つまり個々のパタン画像の矩形サイズとCGPatternCreate()に渡す縦横の展開幅を一致させればOKです。最初の表示がUIViewの背景カラーにセットした場合、後の表示がCALayerの背景カラーにセットした場合です。- (CGPatternRef)getPattern1 // 余白無しパタン(CGPatternRef)作成 { CGPatternCallbacks callbacks={ 0,&drawPatternImage,NULL }; // コールバックルーチン CGPatternRef pattern; CGAffineTransform matrix; CGRect drt; drt=CGRectMake( 0,0,10,10 ); // パターン表示矩形(サイズは一致) matrix=CGAffineTransformMakeScale( 2.0,2.0 ); // 表示スケールを2倍に // コールバックルーチンや変換行列をセットしパターン作成 pattern=CGPatternCreate( NULL,drt,matrix,10,10, kCGPatternTilingConstantSpacing,true,&callbacks ); return pattern; }

この両者を比べると分かりますが、UIViewの背景カラーにセットした場合とCALayerの背景カラーにセットした場合では、パタン図形が描画される座標系が異なりますので注意してください。UIViewでは左上が原点、 CALayerでは左下が原点でパタン図形が描画されます。これは、UIKitとCore Graphicsの描画システムの座標系の違いが反映されている結果です。 -

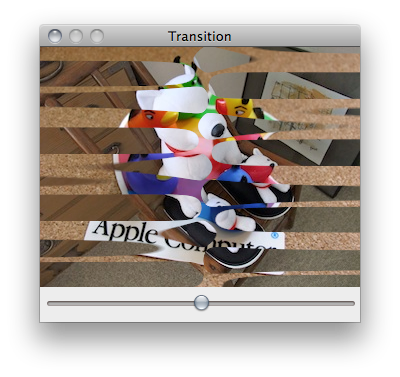

Core Imageのトランジション用フィルタ

この記事は、2013年06月26日に掲載されました。OS X 10.4から採用されたCore Imageフレームワークは、GPUのシェーダプログラムを活用することでリアルタイムイメージプロセッシング(画像や映像のフィルタ処理、合成処理、変形処理)を実現します。 このフレームワーク、iOSにはiOS 5から実装されており、iPhoneやiPadアプリでも画像フィルタの一部が使えるようになりました。またiOS 6からは利用できるフィルタ数も100近くに増えています(OS Xは130以上ある)。

iOS 5では存在せず、iOS 6で初めて実装されたフィルタにCICategoryTransition(トランジション)カテゴリがあります。CICategoryTransitionカテゴリには、2つの画像の表示切り換え(トランジション)時に色々なエフェクトを実行するためのフィルタが集められています。Core Imageでトランジションアニメーションを実行するためには、他のフィルタの場合とは少し異なる処理をソースコードとして記述する必用があります。以下が、iOS 6から利用できるようになったトランジション用フィルタです。

・CIBarsSwipeTransition(バースワイプ)

・CICopyMachineTransition(コピーマシン)

・CIDisintegrateWithMaskTransition(マスクからの分解)

・CIDissolveTransition(ディゾルブ)

・CIFlashTransition(フラッシュ)

・CIModTransition(モッド)

・CISwipeTransition(スワイプ)上記フィルタのうち、 CIFlashTransition(フラッシュ) トランジションを実行するソースを記述してみます。具体的には、アニメーションのためにCADisplayLinkを作成し、そこにトランジション用の実行メソッド(doTransition)を登録します。まず最初は、画像の呼び込みとCore ImageフィルタやCADisplayLinkの準備を行うsetupFilterメソッドです。またフィルタの結果を表示するために、先んじてCIContextも作成しておきます。このメソッドは、ビューコントローラのviewDidLoadメソッドなどから呼び出せばOKでしょう。切り換え用の2つの画像、Image1.jpgとImage2.jpgは、先んじてXcodeプロジェクトに登録しておきます。

- (void)setupFilter // フィルタの準備を行う { NSURL *url; CGRect drt; if( url=[[NSBundle mainBundle] URLForResource:@"Image1" withExtension:@"jpg"] ) sourceImage=[CIImage imageWithContentsOfURL:url]; // ソース画像 if( url=[[NSBundle mainBundle] URLForResource:@"Image2" withExtension:@"jpg"] ) targetImage=[CIImage imageWithContentsOfURL:url]; // テーゲット画像 if( sourceImage && targetImage ) { drt=[sourceImage extent]; // 画像の矩形枠 centerX=drt.size.width/2.0; // フィルタに渡す画像の中心X座標 centerY=drt.size.height/2.0; // フィルタに渡す画像の中心Y座標 ciContext=[CIContext contextWithOptions:nil]; // CIContext作成 // アニメーション用のディスプレイリンクを作成して呼び出すアクションを定義 displayLink=[CADisplayLink displayLinkWithTarget:self selector:@selector(doTransition)]; [displayLink addToRunLoop:[NSRunLoop currentRunLoop] forMode:NSDefaultRunLoopMode]; displayLink.frameInterval=1; // フレームレイト(30fps) displayLink.paused=YES; // アニメーション開始 } }

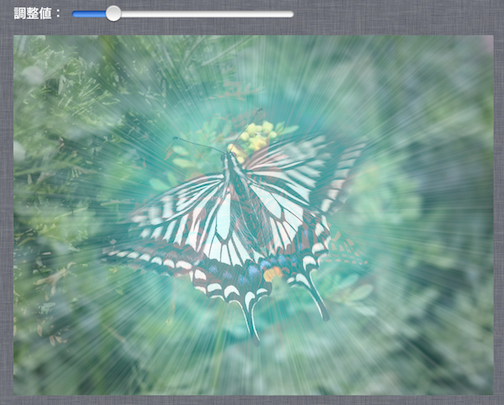

続いて、フィルタに必要な各種パラメータを設定するinitFilterメソッドです。IBOutletとしてスライダー(UISlider)をひとつ用意し、それを動かすことで切換え時のフラッシュの「光の強さ」を調整できるようにします。スライダーの最小値、最大値、初期値は、フィルタにセットするinputStriationStrengthパラメータのアトリビュートを調べる事で得られるので、それぞれをスライダー(imageSlider)側にセットします。それ以外に必要とされるパラメータについては、先んじて適切な値を代入しておきます。

- (void)initFilter // フィルタの初期化を行う { NSDictionary *attribute; displayLink.paused=YES; // アニメーションの一時停止 // CIFlashTransition(フラッシュ)初期パラメータ設定 transitionFilter=[CIFilter filterWithName: @"CIFlashTransition"]; [transitionFilter setValue:[CIVector vectorWithX:centerX Y:centerY] forKey:@"inputCenter"]; [transitionFilter setValue:[CIVector vectorWithX:centerX Y:centerY] forKey:@"inputExtent"]; [transitionFilter setValue:[CIColor colorWithRed:0.0 green:1.0 blue:1.0 alpha:1.0] forKey:@"inputColor"]; [transitionFilter setValue:[NSNumber numberWithFloat:2.58] forKey:@"inputMaxStriationRadius"]; [transitionFilter setValue:[NSNumber numberWithFloat:1.38] forKey:@"inputStriationContrast"]; [transitionFilter setValue:[NSNumber numberWithFloat:0.85] forKey:@"inputFadeThreshold"]; attribute=[[transitionFilter attributes] objectForKey:@"inputStriationStrength"]; // inputStriationStrengthパラメータの最小値、最大値、初期値を得てスライダーに設定 imageSlider.minimumValue=[[attribute objectForKey:kCIAttributeSliderMin] floatValue]; imageSlider.maximumValue=[[attribute objectForKey:kCIAttributeSliderMax] floatValue]; imageSlider.value=[[attribute objectForKey:kCIAttributeDefault]floatValue]; displayLink.paused=NO; // アニメーションの再開 baseTime=0; }

最後は、DisplayLinkから定期的に呼ばれて、フィルタ処理(トランジション)を実行するdoTransitionメソッドです。2つの画像の切換えは、経過時間により順次反転させる(ソース画像とターゲット画像を逆にする)ように調整されています。フィルタ処理により出力された結果(画像)は(transitionFilter.outputImage)はCIImageですので、こちらをCGImageRefに変換した後、最終的にはUIImageにしてから、imageView (UIImageView)のプロパティにセットして表示させています。

- (void)doTransition // 2つの画像でCIFlashTransitionを実行する { CGImageRef cgimage; float time; CGRect drt; if( transitionFilter ) { if( baseTime==0.0 ) baseTime=displayLink.timestamp; // アニメーション開始からの時間経過 time=(displayLink.timestamp-baseTime)*0.5; if( fmodf( time,2.0 ) < 1.0 ) // 2秒で切り換る(ソースとターゲットを交換) { [transitionFilter setValue:sourceImage forKey:@"inputImage"]; [transitionFilter setValue:targetImage forKey:@"inputTargetImage"]; } else { [transitionFilter setValue:targetImage forKey:@"inputImage"]; [transitionFilter setValue:sourceImage forKey:@"inputTargetImage"]; } // CIFlashTransition(光の強さをセット) [transitionFilter setValue:[NSNumber numberWithFloat:imageSlider.value] forKey:@"inputStriationStrength"]; // 切換えタイミングのカーブはcos()を利用して滑らかにする [transitionFilter setValue:[NSNumber numberWithFloat: 0.5*(1.0-cos( fmodf(time,1.0)*M_PI))] forKey:@"inputTime"]; drt=[transitionFilter.outputImage extent]; cgimage=[ciContext createCGImage:transitionFilter.outputImage fromRect:drt]; imageView.image=[UIImage imageWithCGImage:cgimage]; // 結果の描画 CGImageRelease( cgimage ); } } -

ビューコントローラの入れ子状態

この記事は、2013年04月22日に掲載されました。ユーザにカテゴライズされた複数の機能を提供しようとした場合、iOSデバイスでは、ウィンドウは画面サイズと一致していますので、OS Xの様にマルチウィンドウを利用することはできません。そこで、スクリーン内を幾つかのエリアに分け、それぞれの機能を持たせようとすると、ひとつのビューコントローラで複数のビュー(UIView)を管理し、内部的に処理を分岐&分担させる必用があります。 OS Xで言えば、ウィンドウ内を幾つかの表示領域(ペイン)で区分けし、それぞれの領域に別カテゴリーの機能を実装することに一致します(Xcode自身が良い例)。

iPhoneは画面が小さいので、領域を分けることはせず、UINavigationController や UITabBarControllerなどで別のビューコントローラに切り替えるのが常道です。iPadの場合は少し画面が広いので、ポップオーバーを用いたり、UISplitViewControllerでエリアを2つに分けて使う仕組みも用意されています。iOS 6では、そうした仕組みに加えて、Storybordの編集時に、ビューコントローラ(UIViewController)を入れ子状態にして配置することが可能となりました。

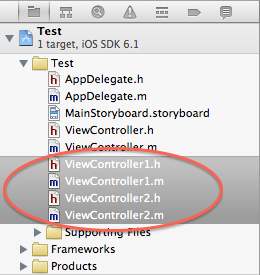

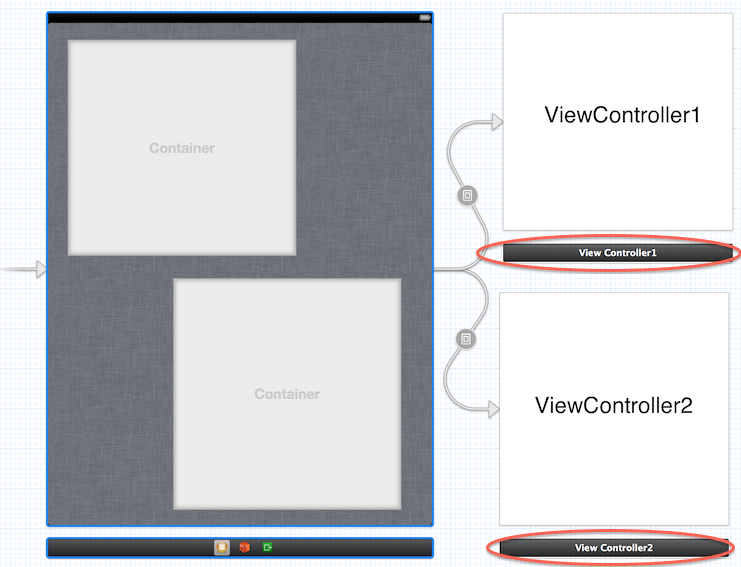

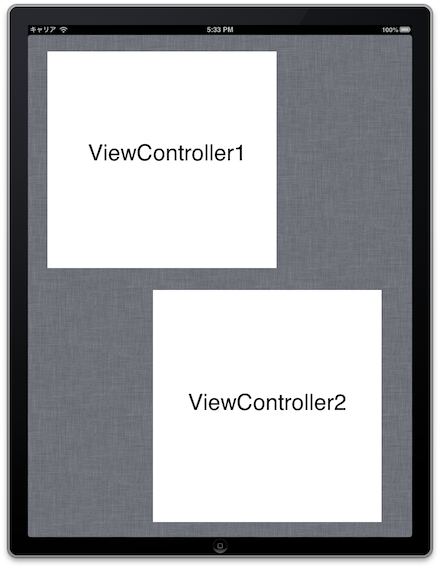

例えば、Xcode 4.6の雛形から「Single View Application」を選んでプロジェクトを新規作成します。この雛形には、ViewControllerというクラスが定義されており、読み込まれるMainStoryboard.storyboardには、そのビューコントローラが登録されています。そこで、ViewControllerクラスのソースファイルとヘッダファイルであるViewController.hとViewController.mをコピーし、新たに2種類のビューコントローラクラス(ViewController1とViewController2)を作成します。

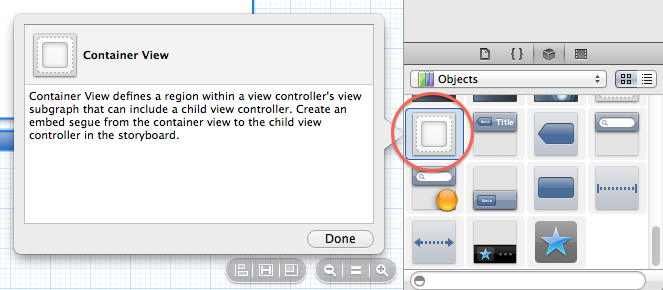

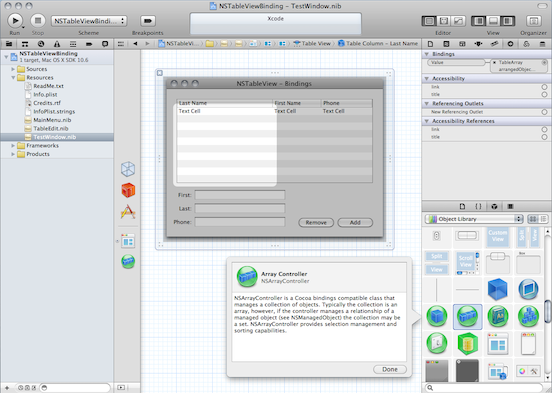

この2つのビューコントローラを、最初からあるViewControllerと入れ子にして配置してみましょう。 ビューコントローラを入れ子にする作業は簡単です。Storybord編集画面でオブジェクトライブラリから「Container View」を選んで、親となるビューコントローラ上にドラッグ&ドロップするだけです。

それにより、それぞれのContainer Viewに対してビューコントローラクラスを設定できるようになります。 ここでは、上部に配置したビューコントローラをViewController1クラスに、下部に配置したビューコントローラをViewController2クラスに設定します。分かり易いように、それぞれにラベルを付けて自身のクラス名を表示しておきます。ちなみに、今までお世話になってきたnibファイル(.xlib)では、こうした編集はできませんのでご注意ください(オブジェクトライブラリにContainer Viewが存在しない)。

ビルドを実行しiOSシミュレータを起動してみると、新しい2つビューコントローラ(ViewController1 と ViewController2)の管理領域(UIView)が、用意されていたビューコントローラ(ViewController)上にレイアウトされていることが分かります。

では、この機能はどんな時に有用なのでしょうか? 例えば、GLKitを利用し画面の複数箇所で3D描画を実行しようとしても、GLKViewControllerとGLKViewが密接に結びついているために困難であることが分かります。具体的には、GLKViewControllerのviewプロパティに代入されるビューが、GLKViewそのものでないとダメな仕様になっているわけです。そこで、別のビューコントローラ上に複数のGLKViewControllerを配置してやれば、それぞれのエリアで別々の3D描画を行う事が可能となります。こうした例からも、とても簡単な仕組みなのですが、その効果は絶大であることが理解できます。

このビューコントローラの入れ子機能、同じくiOS 6から採用されたオートレイアウト機能と組み合わせて「近い将来に大画面用のiOSアプリ(例えばiTV)が開発可能になる証拠では?」と感じているのは筆者だけでしょうか(笑)。

-

iOS 6でEAGLViewをスクリーンキャプチャする

この記事は、2013年02月17日に掲載されました。OpenGL ESで描画した画像のスクリーンキャプチャ(スクリーン画像からUIImagを作成)を実行したい場合があります。GLKitを利用していれば、GLKViewのsnapshotメソッドを使うことで、以下のように簡単に実行できるようになりました。

UIImage *image; image=[gview snapshot]; // GLKViewの表示内容をUIImageとしてキャプチャしかし、iOS 4やiOS 3ではGLKitは使用できませんので、そうしたバージョンがインストールされているデバイスまで起動対象にすると、この方法は不可となります。そこで、GLKitを使わずOpenGL ESのレンダリング画面(EAGLView)をスクリーンキャプチャする方法が、以下のテクニカルQ&Aに紹介されています。

QA1704「OpenGL ES View Snapshot」

実は、iOS 5までは、ここに紹介されているやり方で問題なくEAGLViewの画面をスクリーンキャプチャできました。しかし、iOS 6では若干注意する点があります。EAGLViewの初期化を行う場合には、だいたい以下のような処理をソースコードとして記述します。

EAGLContext *context; if( self=[super initWithFrame:frame] ) { eaglLayer=(CAEAGLLayer *)self.layer; eaglLayer.opaque=YES; eaglLayer.drawableProperties=[NSDictionary dictionaryWithObjectsAndKeys: [NSNumber numberWithBool:YES],kEAGLDrawablePropertyRetainedBacking, kEAGLColorFormatRGBA8,kEAGLDrawablePropertyColorFormat,nil]; context=[[EAGLContext alloc] initWithAPI:kEAGLRenderingAPIOpenGLES1]; ....

ここで、drawablePropertiesにセットするkEAGLDrawablePropertyRetainedBackingの値をYESにする必要があります。こうしておかないと、OpenGL ESでレンダリングした結果がフレームバッファに残りません。よって、データを抽出しても真っ白な画像しか作成できません。iOS 5までは、これをNOに設定しておいても、問題なく画像データを抽出することができました。ひょっとしたら、こちらの方がバグだったのかもしれません? とりあえずOSのバージョンアップと共に仕様が変更されたわけです。テクニカルQ&Aにはソースコードも掲載されていますが、分かりやすく書き直してみましたので参考にしてみてください。引数で渡すのはEAGLViewです。そこから画像の矩形サイズ(横幅と高さ)を得て画像を呼び込むためのバッファ(メモリ領域)を確保しています。その後、glPixelStorei()とglReadPixels()でOpenGL ESのフレームバッファ内の画像を読み込みます。後は、一般的なCore Graphicsの手法でCGImageRefを作成して、最終的にはそこからUIImageを得ています。

UIImage *eglViewCapture( EAGLView *eaglview ) { NSInteger widthInPoints,heightInPoints,i; NSInteger width,height,dataLength; CGColorSpaceRef colorspace; UIImage *image=nil; CGContextRef cgcontext; unsigned long *data; CGFloat scale; CGImageRef iref; CGDataProviderRef ref; width=eaglview.frame.size.width; // ビュー矩形領域の横幅 height=eaglview.frame.size.height; // ビュー矩形領域の高さ dataLength=width*height*sizeof(unsigned long); // 読み込む画像の総容量 if( data=(GLubyte*)malloc( dataLength ) ) // 読み込み用メモリ確保 { glPixelStorei( GL_PACK_ALIGNMENT,4 ); // 画像保フォーマット指定と読み込み glReadPixels( 0,0,width,height,GL_RGBA,GL_UNSIGNED_BYTE,data ); for( i=0;i<width*height;i++ ) // RGBカラーのアルファ値を設定し直す *(data+i)|=0xff000000; // データプロバイダを用意 ref=CGDataProviderCreateWithData( NULL,data,dataLength,NULL ); colorspace=CGColorSpaceCreateDeviceRGB(); // 設定するカラー環境を用意 if( iref=CGImageCreate( width,height,8,32,width*4,colorspace, kCGBitmapByteOrder32Big|kCGImageAlphaPremultipliedLast, ref,NULL,true,kCGRenderingIntentDefault ) ) // まずはCGImageを作成 { // UIImage作成用のコンテキストをセット if( UIGraphicsBeginImageContextWithOptions ) // iOS 4.0以上はこちら { scale=eaglview.contentScaleFactor; // スケールファクタで調整 widthInPoints=width/scale; heightInPoints=height/scale; UIGraphicsBeginImageContextWithOptions( CGSizeMake(widthInPoints, heightInPoints),NO,scale ); } else // iOS 3.xの場合はこちら { widthInPoints=width; heightInPoints=height; UIGraphicsBeginImageContext( CGSizeMake(widthInPoints, heightInPoints)); } cgcontext=UIGraphicsGetCurrentContext(); // CGContextRefを得る CGContextSetBlendMode( cgcontext, kCGBlendModeCopy ); // 描画モード CGContextDrawImage( cgcontext,CGRectMake ( 0.0,0.0,widthInPoints,heightInPoints ),iref ); // CGImageを描画 image=UIGraphicsGetImageFromCurrentImageContext(); // UIImageを得る UIGraphicsEndImageContext(); // UIImage作成用のコンテキストを解放 CGImageRelease( iref ); // CGImageを解放 } CFRelease( colorspace ); // カラー環境を解放 CFRelease( ref ); // データプロバイダーを解放 free( data ); // 確保したメモリの解放 } return image; // 作成されたUIImageを返す }

このルーチンで注目すべきは以下の箇所です。for( i=0;i<width*height;i++ ) // RGBカラーのアルファ値を設定し直す *(data+i)|=0xff000000;

これを実行しておかないと、OpenGL ESのレンダリング処理の実装の仕方によってはアルファ値が正しく設定されておらず、UIImageに変換した時に何も表示されない画像(アルファ値がゼロ)が出来上がってしまいます。テクスチャを使えば大丈夫のようですが、頂点カラーの表示だけを用いたレンダリングではダメな場合があるようです。ご注意ください。 -

Core Imageでビデオ映像にフィルタ処理

この記事は、2012年12月17日に掲載されました。今回は、キャプチャセッションで得られたビデオフレーム画像に対し、Core Imageを使いフィルタ処理を行ってからスクリーンに再度表示する方法を解説します。一度、静止画像としてキャプチャしてからフィルタ処理を行えば簡単ですが、リアルタイム(高速)にフィルタ効果をプレビューする場合には、前回と同様に、キャプチャセッションのメデイアデータ出力形式として「サンプルバッファ(CMSampleBufferRef)」を利用することになります。

まず、どんな画像フォマットでビデオフレームを得るかを指定します。今回も32BGRAを利用しますが、その他にyuvsや2vuyなどのフォーマットも利用可能です。ビデオのフレームデータは設定したデリゲートメソッドに1フレーム単位で入ってきますので、GCDデスパッチキューを作り別スレッドでデリゲートメソッドが実行されるようにします。メソッド名はやはりcaptureOutput:didOutputSampleBuffer:fromConnection:となります。前回は、この処理をメインスレッドで行いましたが、今回はそうでなくても問題なく処理が可能です。

まずは、ビデオフレームの画像処理に用いるCore Imageのフィルタを準備しておきます。今回は色相調整用のCIHueAdjustフィルタを使います。このフィルタのパラメータの変更は、ツールバー上のスライダーでリアルタイムに調整できるようにしておきます。Core Imageに関しては以下の2つのドキュメントを参照してください(和訳は無し)。

「Core Image Programming Guide」(Core Imageプログラミングの詳細な解説)

「Core Image Filter Reference」(Core Image搭載のフィルタのリファレンス)

-(void)setupFilter // Core Imageフィルタ・セットアップ { cicontext=[CIContext contextWithOptions:nil]; // 先んじていCIContextを作成する filter=[CIFilter filterWithName:@"CIHueAdjust"]; // 色相調整フィルター作成 [filter setDefaults]; // 初期値をセット hueValue=0.0; // 色相パラメータ初期値 }キャプチャセッションのセットアップ処理では、デバイス出力としてAVCaptureVideoDataOutputを選び、利用フォーマット(32BGRA)を選択した後にデリゲートメソッド用のGCDデスパッチキューをセットします。今回は、キャプチャセッション自身とフィルタ処理後の両方をスクリーン表示させますので、ビデオプレビュー用レイヤーのAVCaptureVideoPreviewLayerも準備しておきます。もし、フィルタ処理後の映像のみを表示したければ、ソースコードのプレビューレイヤ設定の箇所は省略してもかまいません。

- (BOOL)setupAVCapture // キャプチャセッション・セットアップ { NSDictionary *rgbOutputSettings; AVCaptureDeviceInput *deviceInput; NSError *error=nil; CALayer *rootLayer; AVCaptureSession *session; AVCaptureDevice *device; NSUInteger ret=NO; session=[[AVCaptureSession alloc] init]; // キャプチャセッションのインスタンス作成 // 対象メデイアのプリセット(写真用の最大解像度) [session setSessionPreset:AVCaptureSessionPresetPhoto]; // ビデオ映像読み込みデバイス使用(ディフォルトは背面カメラ) device=[AVCaptureDevice defaultDeviceWithMediaType:AVMediaTypeVideo]; // デバイス入力インスタンス作成 deviceInput=[AVCaptureDeviceInput deviceInputWithDevice:device error:&error]; if( ! error ) { if( [session canAddInput:deviceInput] ) // セッションにデバイス入力を追加 [session addInput:deviceInput]; // 映像フレーム出力インスタンス作成(ビデオのフレームデータを処理する) videoDataOutput=[[AVCaptureVideoDataOutput alloc] init]; // 出力映像フォーマット(32BGRA) rgbOutputSettings=[NSDictionary dictionaryWithObject:[NSNumber numberWithInt:kCMPixelFormat_32BGRA] forKey:(id)kCVPixelBufferPixelFormatTypeKey]; [videoDataOutput setVideoSettings:rgbOutputSettings]; // フォーマット設定 // 逐次ビデオフレームを破棄 [videoDataOutput setAlwaysDiscardsLateVideoFrames:YES]; // ビデオフレーム処理の直列ディスパッチキュー作成 videoDataOutputQueue=dispatch_queue_create( "VideoDataOutputQueue",nil ); // デリゲート用のディスパッチキューを設定 [videoDataOutput setSampleBufferDelegate:self queue:videoDataOutputQueue]; // セッションにビデオフレーム出力(AVCaptureVideoDataOutput)を追加 if( [session canAddOutput:videoDataOutput] ) [session addOutput:videoDataOutput]; // セッションで使うビデオプレビュー用レイヤー作成 previewLayer=[[AVCaptureVideoPreviewLayer alloc] initWithSession:session]; [previewLayer setBackgroundColor:[[UIColor blackColor] CGColor]]; // 背景は黒 [previewLayer setVideoGravity:AVLayerVideoGravityResizeAspect]; // 表示形式 rootLayer=[previewView layer]; // previewViewのレイヤーを得る [rootLayer setMasksToBounds:YES]; // マスクを一致させる [previewLayer setFrame:[rootLayer bounds]]; // previewLayerの矩形枠設定 [rootLayer addSublayer:previewLayer]; // previewLayerを配置 [session startRunning]; // 映像プレビュー開始 ret=YES; } return ret; }次は、1フレームごとのビデオフレームデータを得るためのデリゲートメソッドです。CMSampleBufferRefからCMSampleBufferGetImageBuffer()ルーチンを使いCore Videoのピクセルバッファ(CVPixelBufferRef)を得ます。このピクセルバッファには画像データが32BGRAフォーマットで格納されています。続いてフィルタ処理の対象とするCIImageを、initWithCVPixelBuffer:options:メソッドで作成します(対象はUIImageではないので注意!)。回転とミラー反転などの座標変換後に、得られたCIImageを入力画像としてパラメータのinputAngleを変更し色相調整フィルタ処理を実行します。変更値はツールバー上のスライダーからの値です。そして結果としての出力画像を新規のCIImageとして得ることができます。

得られたCIImage(フィルタ処理済み)をスクリーン上に配置したUIImageViewへ表示します。この処理はメインスレッドで行う必要がありますので、dispatch_async()のブロック処理として実装します。手順としては、createCGImage:fromRect:でCIImageからCGImageRefを作り、さらにimageWithCGImage:メソッドでUIImageを作成してUIImageViewのimageプロパティにセットします。

// ビデオデータ読み込みデリゲート (void)captureOutput:(AVCaptureOutput *)captureOutput didOutputSampleBuffer: (CMSampleBufferRef)sampleBuffer fromConnection: (AVCaptureConnection *)connection { CIImage *ciimage,*ciimage1,*ciimage2; CVPixelBufferRef pixelBuffer; CFDictionaryRef attachments; CGAffineTransform tt; // CMSampleBufferRefからピクセルバッファ(CVPixelBufferRef)を得る pixelBuffer=CMSampleBufferGetImageBuffer( sampleBuffer ); // 追加情報を得る attachments=CMCopyDictionaryOfAttachments( kCFAllocatorDefault,sampleBuffer, kCMAttachmentMode_ShouldPropagate ); // CIImageを作成する ciimage=[[CIImage alloc] initWithCVPixelBuffer:pixelBuffer options: (__bridge NSDictionary *)attachments]; tt=CGAffineTransformMakeRotation( -M_PI/2.0 ); // 90度回転 if( isFrontCamera==YES ) // 前方カメラの場合ミラー反転させる tt=CGAffineTransformScale( tt,1.0,-1.0 ); ciimage1=[ciimage imageByApplyingTransform:tt]; // CIImageの表示方向を指定する [filter setValue:ciimage1 forKey:@"inputImage"]; // 入力画像設定とフィルタ処理実行 [filter setValue:[NSNumber numberWithFloat:hueValue] forKey:@"inputAngle"]; if( ciimage2=filter.outputImage ) // フィルタ処理の出力画像を得る { // メインスレッドディスパッチキュー dispatch_async( dispatch_get_main_queue(), ^{ CGImageRef cgimage; cgimage=[cicontext createCGImage:ciimage2 fromRect:[ciimage2 extent]]; imageView.image=[UIImage imageWithCGImage:cgimage]; CGImageRelease( cgimage ); // UIImageViewに表示する }); } if( attachments ) CFRelease(attachments); }以上の処理で、ビデオフレーム画像に対してリアルタイムでフィルタ処理を実行し、その結果を再度スクリーンに表示することが可能です。もし、UIImageViewへの表示では処理が遅いと感じるようなら、CALayerへダイレクトに表示させることも可能です。ぜひ、チャレンジしてみてください。

-

ビデオ映像をOpenGLテクスチャとして使う

この記事は、2012年10月27日に掲載されました。AV Foundationは、iOS 4.0 以降とOS X 10.7(Lion)以降で利用できるフレームワークでして、タイムベースのオーディオ&ビジュアルメディアの作成、記録、再生などに活用します。こフレームワークを用いれば、ビデオカメラから取り込んだ映像(フレーム画像)を、ダイレクトにOpenGLテクスチャとして活用できます。今までもこうした処理を実現する方法は幾つかありました。しかし、逐次画像変換による処理スピードの低下が問題だったため、iOS 5からCore Videoに画像変換処理を経由しないテクスチャ利用の仕組みが導入されています(CVOpenGLESTextureCache.h)。

ビデオ映像を得るためには、先んじてキャプチャセッション(AVCaptureSession)を作成し、それのセットアップを行います。1フレーム毎のビデオフレーム画像を「サンプルバッファ(CMSampleBufferRef)」として入手するため、デバイス出力としてAVCaptureVideoDataOutputを作成してセッションに登録しておきます。デリゲートでサンプルバッファから得られたピクセルバッファ(CVImageBufferRef)をOpenGLテクスチャとするためには、CVOpenGLESTextureCacheCreate()ルーチンを使い、キャッシュ用のリファレンス(CVOpenGLESTextureCacheRef)を準備しておく必要があります。

// キャッシュリファレンス作成(CVImageBufferRefとテクスチャ変換用) CVOpenGLESTextureCacheCreate( kCFAllocatorDefault,NULL, glContext, NULL,&videoTextureCache) )

OpenGLでの処理の制限上、デリゲートメソッドはメインランループ(スレッド)上で実行されるように、別スレッド指定ではなく、dispatch_get_main_queue()を引数に渡してメインスレッド用のデスパッチキューを作成します。

// デリゲート用のディスパッチキューを設定(メインスレッド) videoDataOutput setSampleBufferDelegate:self queue:dispatch_get_main_queue()];

以下は、ビデオフレーム画像をOpenGLテクスチャとして利用するためのキャプチャセッションのセットアップ例です。 今回はスクリーン全体に対してOpenGL経由の表示が行われますので、キャプチャセッション自身のビデオプレビューは必要ありません。そのため、それに関係する処理はすべて外してあります。

- (BOOL)setupAVCapture // キャプチャセッション・セットアップ { NSDictionary *rgbOutputSettings; AVCaptureDeviceInput *deviceInput; NSError *error=nil; AVCaptureDevice *device; NSUInteger ret=NO; // キャッシュリファレンス作成(CVImageBufferRefとテクスチャ変換用) if( ! CVOpenGLESTextureCacheCreate( kCFAllocatorDefault,NULL,glContext, NULL,&videoTextureCache) ) { session=[[AVCaptureSession alloc] init]; // キャプチャセッションインスタンス作成 // 対象メデイアのプレセット( 写真用の最大解像度) [session setSessionPreset:AVCaptureSessionPresetPhoto]; // ビデオ映像読み込みデバイス使用(デフォルトは背面カメラ) device=[AVCaptureDevice defaultDeviceWithMediaType:AVMediaTypeVideo]; // デバイス入力インスタンス作成 deviceInput=[AVCaptureDeviceInput deviceInputWithDevice:device error:&error]; if( ! error ) { // セッションにデバイス入力(AVCaptureDeviceInput)を追加 if( [session canAddInput:deviceInput] ) [session addInput:deviceInput]; // 映像フレーム出力インスタンス作成(ビデオフレームデータを得るため) videoDataOutput=[[AVCaptureVideoDataOutput alloc] init]; // 出力映像フォーマット(32BGRA) rgbOutputSettings=[NSDictionary dictionaryWithObject:[NSNumber numberWithInt:kCMPixelFormat_32BGRA] forKey:(id)kCVPixelBufferPixelFormatTypeKey]; // ビデオフォーマット設定 [videoDataOutput setVideoSettings:rgbOutputSettings]; // 逐次ビデオフレームを破棄 [videoDataOutput setAlwaysDiscardsLateVideoFrames:YES]; // デリゲート用のディスパッチキューを設定(メインスレッドで実行) [videoDataOutput setSampleBufferDelegate:self queue:dispatch_get_main_queue()]; // セッションに映像フレーム出力(AVCaptureVideoDataOutput)を追加 if( [session canAddOutput:videoDataOutput] ) [session addOutput:videoDataOutput]; [session startRunning]; // キャプチャセッション開始 ret=YES; } } return ret; }

以下がビデオフレームデータを得るためのデリゲートメソッドです。最初にサンプルバッファからピクセルバッファ(CVPixelBufferRef)を得ます。その後、CVOpenGLESTextureCacheCreateTextureFromImage()ルーチンでOpenGLテクスチャ(CVOpenGLESTextureRef)を作り、それを使いglBindTexture()を実行してから、glTexParameteri()でテクスチャの表示用パラメータを設定します。

// ビデオデータ読み込みデリゲート (void)captureOutput:(AVCaptureOutput *)captureOutput didOutputSampleBuffer: (CMSampleBufferRef)sampleBuffer fromConnection: (AVCaptureConnection *)connection { size_t width,height; CVPixelBufferRef pixelBuffer; // CMSampleBufferRefからピクセルバッファ(CVPixelBufferRef)を得る pixelBuffer=CMSampleBufferGetImageBuffer( sampleBuffer ); width=CVPixelBufferGetWidth( pixelBuffer ); // ピクセルバッファの横幅 height=CVPixelBufferGetHeight( pixelBuffer ); // ピクセルバッファの高さ [self cleanUpTexture]; // 現在にテクスチャを解放(自作メソッド) // CVPixelBufferRefからテクスチャを作成(Core Video) if( ! CVOpenGLESTextureCacheCreateTextureFromImage(kCFAllocatorDefault, videoTextureCache,pixelBuffer,NULL,GL_TEXTURE_2D,GL_RGBA, width,height,GL_BGRA,GL_UNSIGNED_BYTE,0,&glTexture) ) { // OpenGLテクスチャの使用宣言とテクスチャ用パラメータの設定 glBindTexture( CVOpenGLESTextureGetTarget(glTexture), CVOpenGLESTextureGetName(glTexture) ); glTexParameteri(GL_TEXTURE_2D,GL_TEXTURE_MIN_FILTER,GL_NEAREST); glTexParameteri(GL_TEXTURE_2D,GL_TEXTURE_MAG_FILTER,GL_NEAREST); glTexParameteri(GL_TEXTURE_2D,GL_TEXTURE_WRAP_S,GL_CLAMP_TO_EDGE); glTexParameteri(GL_TEXTURE_2D,GL_TEXTURE_WRAP_T,GL_CLAMP_TO_EDGE); } } - (void)cleanUpTexture // テクスチャの削除 { if( glTexture ) { CFRelease( glTexture ); // CVOpenGLESTextureRefを削除する glTexture=NULL; } CVOpenGLESTextureCacheFlush( videoTextureCache,0 ); // キャッシュクリア実行 }こうして得られたテクスチャ画像は、iOS 5.0から導入されたGLKitを利用して3Dオブジェクトに貼付けて描画するのが簡単です。

そこで、MOSAでは、2012年12月13日(木) 筆者によるiOSアプリでのOpenGL ESとGLKitの活用方法やGLKitが追加搭載された背景を解説するセミナー「OpenGL環境にGLKitが追加された背景を探る」を開催いたします。本セミナーでは、iOSアプリでのOpenGL ESとGLKitの活用方法やGLKitが追加搭載された背景を解説しあます。具体的には、OpenGL ESやGLKitを用いた効果的で高速な2D描画、アニメーション、画像処理などについてサンプルソースコードを提示しながら詳しく解説を致します。多くの方のご参加をお待ちしております!

-

キーフレームアニメーションの実行

この記事は、2012年09月15日に掲載されました。前回は、明示的アニメーションの仕組みと、簡単な例について解説しました。今回は、明示的アニメーションを使う目的はコレと言っても良い、キーフレームアニメーションについて解説したいと思います。

CAKeyframeAnimationクラスてがサポートしているキーフレームアニメーションは、CABasicAnimationに似ていますが、対象となるプロパティ値の配列(複数のプロパティ値)を保持することができます。これらをキーフレーム値と呼びます。配列に保存されたキーフレーム値は、アニメーションの実行中にそれぞれ順番に補間されて表示に使われます。キーフレーム値は、CAKeyframeAnimationオブジェクトのpathプロパティに設定したCore Graphicsパス図形か、valuesプロパティに設定したオブジェクトの配列のどちらかとなります。つまり、pathプロパティがセットされている場合にはvaluesプロパティは無視されるわけです。

以下は、Core Graphics APIで定義したパス図形(ベジュ関数)の軌跡上を移動するアニメーションの一例です。

(IBAction) doKeyFrameAnime // パスに沿って移動させるアニメーション { CALayer *layer; CAKeyframeAnimation *anime; CGMutablePathRef path; layer=myView.layer; path=CGPathCreateMutable(); // Core Graphicsパス図形作成 CGPathMoveToPoint( path,NULL,74.0,74.0 ); // パス図形の定義 CGPathAddCurveToPoint( path,NULL,74.0,500.0,320.0,500.0,320.0,74.0 ); CGPathAddCurveToPoint( path,NULL,320.0,500.0,566.0,500.0,566.0,74.0 ); // パス図形によるキーフレーム値(CGPoint)は位置(position)を示す anime=[CAKeyframeAnimation animationWithKeyPath:@"position"]; anime.path=path; // Core Graphicsパス図形を設定 anime.duration=5.0; // 1サイクル5秒 anime.removedOnCompletion=NO; // 終了時にアニメを消さない anime.FillMode=kCAFillModeForwards; // 終了時の表示を維持する anime.rotationMode=kCAAnimationRotateAuto; // 移動方向に向き回転する [layer addAnimation:anime forKey:nil]; // アニメーション実行 CFRelease( path ); }

rotationModeプロパティにkCAAnimationRotateAutoをセットすると、移動アニメーションを実行する時に、進行方向に対していつも正面を向くようにCALayerの表示が回転されます。また、kCAAnimationRotateAutoReverseをセットすると進行方向に対して逆を向くように回転します。このプロパティに何もセットしなければ、アニメーション中にCALayerの回転は起こりません。pathプロパティではなく、対象オブジェクトの配列(NSArray)をvaluesプロパティにセットすると、任意タイプのCALayerプロパティの変化をアニメーション化することが可能です。例えば、frameプロパティの変化ならCGRect構造体(NSValueにラップ)を、transformプロパティの変化ならCATransform3D構造体(NSValueにラップ)を、contentsプロパティならCGImageを配列に保存することになります。以下は3秒間で2つの画像を切り替えるアニメーションです。表示の切り替えにはフェイドエフェクト(アルファ値が徐々に切り替わる)が利用されます。

- (IBAction) doKeyFrameAnimation // 2つの画像を切り替えるアニメーション { UIImage *image1,*image2; CALayer *layer; CAKeyframeAnimation *anime; image1=[[UIImage imageNamed:@"image1.png"]retain]; // 最初の画像 image2=[[UIImage imageNamed:@"image2.png"]retain]; // 次の画像 layer=myView.layer; // values配列のキーフレーム値は表示画像(contents)を示す anime=[CAKeyframeAnimation animationWithKeyPath:@"contents"]; anime.values=[NSArray arrayWithObjects:(id)image1.CGImage, (id)image2.CGImage,nil]; anime.duration=3.0; // 1サイクル3秒 anime.removedOnCompletion=NO; // 終了時にアニメを消さない anime.FillMode=kCAFillModeForwards; // 終了時の表示を維持する [layer addAnimation:anime forKey:nil]; // アニメーション実行 }

CAKeyframeAnimationではtimingFunctionプロパティは無視され、timingFunctionsプロパティに設定されたCAMediaTimingFunctionオブジェクトの配列が使われます。

@property(copy) NSArray *timingFunctions; // timeFunctionの代わり

またdurationプロパティの方は有効ですが、keyTimesプロパティを使いタイミングをより細かく調節できます。keyTimesプロパティには、各キーフレームセグメントの再生時間を定義するNSNumberオブジェクトの配列を代入します。配列内の値は浮動小数点数であり0.0から1.0の範囲に制限されます。それぞれがValues配列内の各要素に対応しており、対応するキーフレーム値の再生時間を、そのアニメーションの合計再生時間に対する割合として定義しています。配列に保存する浮動小数点数値は、直前の値よりも大きいか同じでなければいけません。以下の例では、4座標を指示して移動アニメーションを実行しています。アニメーションの1サイクルは10秒で終わりますが、その時間配分がkeyTimesプロパティで指示されています。また、その配分や保管方法はcalculationModプロパティで指定できます。

- (IBAction) doKeyFrameAnime // 4座標を経路にして移動させるアニメーション { CGPoint pt1,pt2,pt3,pt4; CALayer *layer; CAKeyframeAnimation *anime; layer=myView.layer; pt1.x=pt1.y=pt2.x=pt4.y=200.0; // 移動座標の代入(4点) pt2.y=pt3.x=pt3.y=pt4.x=600.0; // 移動アニメーションを4座標をCGPoint値で指示 anime=[CAKeyframeAnimation animationWithKeyPath:@"position"]; anime.values=[NSArray arrayWithObjects:[NSValue valueWithCGPoint:pt1], [NSValue valueWithCGPoint:pt2], [NSValue valueWithCGPoint:pt3], [NSValue valueWithCGPoint:pt4],nil]; anime.duration=10.0; // 1サイクル10秒 anime.calculationMode=kCAAnimationCubic; // スプライン補間 // 各ポイントまでの時間配分を0.0から1.0の浮動小数点で指示 anime.keyTimes=[NSArray arrayWithObjects: [NSNumber numberWithFloat:0.0],[NSNumber numberWithFloat:0.1], [NSNumber numberWithFloat:0.5],[NSNumber numberWithFloat:1.0f],nil]; [layer addAnimation:anime forKey:nil]; // アニメーション実行 }

calculationModは5種類から選択可能です。例ではkCAAnimationCubicが選択されており、時間も各座標への移動経路もスプライン補間されます。スプライン補間方法は、tensionValues 、continuityValues 、biasValuesの3つのプロパティで調整することも可能です。

CA_EXTERN NSString * const kCAAnimationLinear; // リニア補間 CA_EXTERN NSString * const kCAAnimationDiscrete; // 補間なし CA_EXTERN NSString * const kCAAnimationPaced; // ペース変更なし(無視) CA_EXTERN NSString * const kCAAnimationCubic; // スプライン補間 CA_EXTERN NSString * const kCAAnimationCubicPaced; // 同上ペース変更なし @property(copy) NSArray *tensionValues, *continuityValues, *biasValues;

今回は、明示的アニメーションを使う目的はコレと言っても良い、キーフレームアニメーションについて解説しました。今回をもってCore Animationに関する解説は終了となります。予定されているMOSADeN Onlineの改装にあわせて、次回からは別の形でiOSやOS Xの旬な話題を提供できればと考えております。 -

明示的アニメーションで変化を拾う

この記事は、2012年08月27日に掲載されました。前回は、UIViewアニメーション機能について詳しく解説しました。今回は、いよいよ明示的アニメーションの詳細に進みます。その先には、キーフレームアニメーションのようなCore Animationスペシャルな機能が待っています。

明示的アニメーションにおいて、処理の中心となるクラスは「CATransition」と「CABasicAnimation」と「CAKeyFrameAnimation」です。もう一つのCAPropertyAnimationクラスは、CABasicAnimationとCAKeyFrameAnimationクラスが継承しているCAAnimationクラスの抽象サブクラスです。

「CABasicAnimation」は、CALayerの2つのプロパティ値(開始値と終了値)の間を線形補間したアニメーションを実行します。こうした種類のアニメーションのほとんどは、暗黙的アニメーションとして実行することも可能です。

「CAKeyframeAnimation」は、キーフレームアニメーションをサポートします。アニメーション化するCALayerプロパティのキーパスと、アニメーションの各場面のプロパティ値の配列、およびキーフレームの時間とタイミング関数の配列を指定してアニメーションを実行します。アニメーションが実行される度に指定された補間を使って各値が設定し直されます。

「CATransition」は、CALayerのコンテンツ全体に作用するトランジション(場面転換)エフェクトを提供します。トランジションエフェクトの種類としてはフェード、プッシュ、リビールなどが用意されています。OS Xに限り、Core Imageのカスタムフィルタを指定することによって、デフォルトのトランジションエフェクトを拡張できます。

まずは簡単な明示的アニメーションの簡単な例を取り上げてみます。CALayerの矩形サイズが縮小(縦横100ピクセル)される動きをアニメーション化したものです。この明示的アニメーションには、CABasicAnimationクラスを利用します。

- (IBAction)doExplicitAnimation:(id)sender // iOSの場合の明白的アニメーション { CABasicAnimation *anime; CALayer *layer; CGRect srt,drt; layer=myView.layer; // 画像レイヤを得る(UIView) // アニメション作成(対象はboundsプロパティ) anime=[CABasicAnimation animationWithKeyPath:@"bounds"]; srt=layer.bounds; // 開始矩形サイズ drt=CGRectInset( srt,50,50); // 終了矩形サイズ(縦横100ピクセル縮小) // 開始と終了値をvalueWithCGRectでNSValueへ変換して代入する anime.fromValue=[NSValue valueWithCGRect:srt]; anime.toValue=[NSValue valueWithCGRect:drt]; [layer addAnimation:anime forKey:@"boundsAnimation"]; // アニメを実行 }

animationWithKeyPath:メソッドで渡している文字列「bounds」がアニメーション(変化)の対象に指定するプロパティ名となります。 その後CABasicAnimationオブジェクトのfromValueプロパティに開始値(NSValue)を、toValueプロパティに終了値(NSValue)を代入してからアニメーションの対象とするCALayerオブジェクトに対しaddAnimation:forKey:メッセージを送ります。この場合forKey:に渡す引数はnilでもかまいません(その場合は名前指定なし)。注意点は、fromValueとtoValueプロパティに渡すのは構造体や数値そのものではなくて、それらをラップした「オブジェクト」だということです。上の例の場合、iOSではプロパティに渡すべき値はCGRect構造体ですが、OS XではNSRect構造体となりますので注意してください。CGRect構造体はvalueWithCGRect:メソッドでNSValueオブジェクトにラップしてからプロパティに代入します。各構造体からNSValueへの変換メソッドは、ヘッダーファイルのUIGeometory.hやCATransform3D.hに定義されています。

+ (NSValue *)valueWithCGPoint:(CGPoint)point; + (NSValue *)valueWithCGSize:(CGSize)size; + (NSValue *)valueWithCGRect:(CGRect)rect; + (NSValue *)valueWithCGAffineTransform:(CGAffineTransform)transform; + (NSValue *)valueWithCATransform3D:(CATransform3D)t;

プロパティへ浮動小数点や整数を渡す場合には、NSNumberオブジェクトでラップします。これを担当するメソッドはNSNumberクラス(NSNumber.h)に定義されています。例えば、CALalyerのopacity(アルファ値)を1.0からゼロへ変化させると、表示された画像がだんだんと透明になって消えていくアニメーションを実現できます。この設定には、numberWithFloat:メソッドを使っていることが分かります。

anime.fromValue=[NSNumber numberWithFloat:1.0]; anime.toValue=[NSNumber numberWithFloat:0.0];

CAAnimationでは「キーパス」を使うことで選択した構造体の各フィールドにアクセスすることができます。これは、いちいち構造体フィールド全部をfromValueやtoValueプロパティに渡す必要がないことを意味しています。例えばtransform(CATransform3D)プロパティのマトリックス演算子のうち、Z軸方向の回転角度(ラディアン)だけを変更するアニメーションを行う場合には、次のように記述できます。このアニメーションでは、CALayer自身が360度回転するのに1秒かかり、それを全部で3回転させます。

#define M_PI 3.14159265358979323846 layer=myView.layer; anime =[CABasicAnimation animationWithKeyPath:@"transform.rotation.z"]; anime.duration=1.0; anime.repeatCount=3; anime.fromValue=[NSNumber numberWithFloat: 0.0]; anime.toValue=[NSNumber numberWithFloat:M_PI*2]; [layer addAnimation:anime forKey:nil];

明示的アニメーションで、どのようなキーパスが利用できるかかについて把握するには、 和訳されたドキュメント「Core Animationプログラミングガイド」のp27「キーパスを使った変換の変更」の一覧表を参考にするのが近道です。以下は、画面上にレイアウトしたUIView(UIImageViewなどでもOK)を心臓の鼓動のように1回だけ「ドックン」と脈動させるルーチン例です。 明示的アニメーションでは、アニメーションの時間軸を制御するタイミング関数(三次元ベジェ曲線)を選択可能です。kCAMediaTimingFunctionDefaultを使うと、ゆっくりとスタートし、徐々に加速、そしてまた減速して止まるという時間軸カーブに沿ったアニメーションを実現できます。例としては、MacのDockに登録されているアイコンのジャンプのような動きだと思ってください。このカーブをリニア(直線)のkCAMediaTimingFunctionLinearに切り換えて、アニメーションの雰囲気がどんな風に変わるのかを試してみるのも面白いかもしれません。

// 脈動アニメーション void pulseAnimation( UIView *view,float duration,float scale,id delegate ) { CABasicAnimation *anime1,*anime2; CATransform3D trans3d; CAAnimationGroup *group; CALayer *layer; layer=[view layer]; anime1=[CABasicAnimation animationWithKeyPath:@"opacity"]; // アルファ値対象 anime1.fromValue=[NSNumber numberWithFloat:1.0]; anime1.toValue=[NSNumber numberWithFloat:0.5]; anime2=[CABasicAnimation animationWithKeyPath:@"transform"]; // 座標変換対象 trans3d=CATransform3DMakeScale( 1.0,1.0,1.0 ); anime2.fromValue=[NSValue valueWithCATransform3D:trans3d]; trans3d=CATransform3DMakeScale( scale,scale,scale ); // 拡大スケール指定 anime2.toValue=[NSValue valueWithCATransform3D:trans3d]; group=[CAAnimationGroup animation]; // グループ指定 group.delegate=delegate; group.duration=duration; // 1サイクルに有する時間 group.autoreverses=YES; // リバースアニメーション group.timingFunction=[CAMediaTimingFunction functionWithName:kCAMediaTimingFunctionDefault]; // 制御関数指定 group.animations=[NSArray arrayWithObjects:anime1,anime2,nil]; // グループ登録 [layer addAnimation:group forKey:@"startAnimation"]; // アニメーション開始 }

CAAnimetionクラスにはCAAnimationDelegateとして2つのメソッドが定義されており、delegateプロパティをセットしておくことでアニメーションの開始時と終了時に適切な処理を呼び出すことが可能です。このデリゲートをうまく利用すれば、あるアニメーションが終了した時点で別のアニメーションを開始するようなことが可能です。

- (void)animationDidStart:(CAAnimation *)anim; // 開始時 (void)animationDidStop:(CAAnimation *)anim finished:(BOOL)flag; // 終了時

今回は、明示的アニメーションの仕組みと、簡単な例について解説しました。次回は、明示的アニメーションを使う目的はコレと言っても良い、キーフレームアニメーションについて解説したいと思います。 -

お手軽なUIViewアニメーションを使う

この記事は、2012年05月23日に掲載されました。前回は、CATransactionクラスの仕組みと、UIView自身のアニメーション機能が存在していることについてお話しました。今回は、UIViewアニメーション機能についてさらに詳しく解説いたします。

まず最初に、UIViewクラスのアニメーション機能を利用した一例を見てみます。前回で解説したトランザクション定義との類似性が理解できます。この時、アニメーションを引き起こすプロパティ変更はUIView対象であり、CALayer対象ではありませんので注意してください。iOSの場合、この機能のおかげでCALayerに対して直接アニメーションを実行すべきケースは少ないと思われます(OS Xにはない)。

- (IBAction)doAnime:(id)sender // UIViewのアニメーション { CGRect drt; [UIView beginAnimations: nil context:NULL]; // アニメ定義開始 [UIView setAnimationDuration:3.0]; // 1サイクル3.0秒 [UIView setAnimationRepeatAutoreverses:YES]; // 巻き戻しを行う [UIView setAnimationRepeatCount:2]; // 2回繰り返す drt=myView.frame; drt.origin.x+=100; myView.frame=drt; [UIView commitAnimations]; // アニメ定義終了 }

対象クラスがUIViewを継承していれば、コントロールやツールバーなどでも同様な手段が取れます。つまり、UIKitで使えるユーザインターフェース(UI)関連のオブジェクトは、ほとんど全てアニメーションの対象となるわけです。以下は、ツールバーをじわっと(0.5秒)消していくアニメーションの一例です。

- void setToolbarAlpha( UIToolbar *toolbar,CGFloat alpha ) { [UIView beginAnimations:nil context:NULL]; // アニメ定義開始 [UIView setAnimationDuration:0.5]; // 1サイクル0.5秒 toolbar.alpha=alpha; // ツールバーを非表示にする場合はアルファ値をゼロに [UIView commitAnimations]; // アニメ定義終了 }

続いて、UIViewのトランジション(切り替え)アニメーションの例です。 ビューを追加や削除する操作が引きがねとなりトランジション(めくり効果)アニメーションが実行されます。

- (void)close // 画像を閉じる { [UIView beginAnimations:nil context:NULL]; // アニメ定義開始 [UIView setAnimationDuration:1.0]; // 1サイクル1.0秒 [UIView setAnimationTransition:UIViewAnimationTransitionCurlDown forView:myViewController.view cache:YES]; // トランジション指定 [self.view removeFromSuperview]; // スパービューから外す [UIView commitAnimations]; // アニメ定義終了 }

次の例は、transformプロパティを変更することで、UIViewをアニメーションさせながら回転&ミラー反転させるルーチンです。引数のdur(NSTimeInterval)でアニメーションを何秒実行するのかを指示します。回転とミラー反転の組み合わせから7種類の変換タイプが選択できます。ここでの対象はUIImageViewですので、このビューに表示されている画像(UIImage)も指示に従い回転やミラー反転表示されます。

#define M_PI 3.14159265358979323846 void rotateView( UIImageView *iview,NSUInteger type,NSTimeInterval dur ) { CGAffineTransform tt; [UIView beginAnimations:nil context:NULL]; // アニメ定義開始 [UIView setAnimationDuration:dur]; // 1サイクルの時間指示 if( type==0 ) // 正常位置 iview.transform=CGAffineTransformIdentity; else if( type==1 ) // +90度 iview.transform=CGAffineTransformMakeRotation( M_PI/2.0 ); else if( type==2 ) // -90度 iview.transform=CGAffineTransformMakeRotation( -M_PI/2.0 ); else if( type==3 ) // 180度 iview.transform=CGAffineTransformMakeRotation( M_PI ); else if( type==4 ) // 上下反転 iview.transform=CGAffineTransformMakeScale( 1.0,-1.0 ); else if( type==5 ) // 左右反転 iview.transform=CGAffineTransformMakeScale( -1.0,1.0 ); else if( type==6 ) // 上下+90度 { tt=CGAffineTransformMakeScale( 1.0, -1.0 ); iview.transform=CGAffineTransformRotate( tt, M_PI/2.0 ); } else if( type==7 ) // 左右+90度 { tt=CGAffineTransformMakeScale( -1.0,1.0 ); iview.transform=CGAffineTransformRotate( tt, M_PI/2.0 ); } [UIView commitAnimations]; // アニメ定義終了 }

iOS 4.0から、UIViewのアニメーション処理をブロック(Block)で引き渡すことのできるメソッドが用意されました。それはらは、UIViewのUIViewAnimationWithBlocksカテゴリーにまとめられています。現在は5種類のクラスメソッドが定義されています。このうち幾つかのメソッドでは、アニメーション実行時のオプション(反転や速度カーブの種類など)をフラグ値(UIViewAnimationOptions)としてセットすることが可能となっています。・UIViewAnimationWithBlocksカテゴリー

+ (void)animateWithDuration:(NSTimeInterval)duration delay: (NSTimeInterval)delay options:(UIViewAnimationOptions)options animations: (void (^)(void))animations completion:(void (^)(BOOL finished))completion; + (void)animateWithDuration:(NSTimeInterval)duration animations: (void (^)(void))animations completion:(void (^)(BOOL finished))completion; + (void)animateWithDuration:(NSTimeInterval)duration animations: (void (^)(void))animations; + (void)transitionWithView:(UIView *)view duration:(NSTimeInterval)duration options:(UIViewAnimationOptions)options animations: (void (^)(void))animations completion:(void (^)(BOOL finished))completion; +(void)transitionFromView:(UIView *)fromView toView:(UIView *)toView duration: (NSTimeInterval)duration options:(UIViewAnimationOptions)options completion: (void (^)(BOOL finished))completion;

例えば、2つのUIImageViewを用意し、片方のalphaプロパティ値に0.0を代入し非表示としておきます。ボタンタップで両ビューの表示と非表示をアニメーション(3秒間)させながら切り換えるのには、iOS 3.0までは以下の様なソースコードを記述していました。

- (IBAction)switchDisplay // 通常処理(ブロックを利用しない) { [UIView beginAnimations:nil context:nil]; [UIView setAnimationDuration:3.0]; imageView1.alpha=0.0; imageView2.alpha=1.0; [UIView commitAnimations]; }

ブロック処理を渡せるアニメーション用クラスメソッドを使うと、まったく同じ処理を簡潔に記述できます。この処理において切り換え方向を逆転させるには、現在のビューのalphaプロパティ値をチェックしておけばOKです。

- (IBAction)switchDisplay // ブロックを利用 { [UIView animateWithDuration:3.0 animations: ^{ imageView1.alpha=0.0; imageView2.alpha=1.0; }]; }

こうしたクラスメソッドには、アニメ終了時の処理をブロックとして記述できるタイプもあります。 以下は、ビデオキャプチャ時にスクリーン(flashView)を一瞬だけ光らせる処理(フラッシュ効果)をブロック処理アニメーションで実装した例です。キー値監視により、 isCapturingStillImageプロパティが変化した時に実行されます。アニメ終了時のブロック処理では、不要となったビュー自体を破棄していることが分かります。

// フラッシュ効果(capturingStillImageプロパティが変化した時呼ばれる) (void)observeValueForKeyPath:(NSString *)keyPath ofObject:(id)object change: (NSDictionary *)change context:(void *)context { BOOL isCapturingStillImage; isCapturingStillImage=[[change objectForKey:NSKeyValueChangeNewKey] boolValue]; if( isCapturingStillImage ) { // フラッシュ用ビューを作成 flashView = [[UIView alloc] initWithFrame:[previewView frame]]; [flashView setBackgroundColor:[UIColor whiteColor]]; // 背景は白色 [flashView setAlpha:0.0]; // アルファ値はゼロ [[[self view] window] addSubview:flashView]; // ウィンドウに配置 [UIView animateWithDuration:0.4 animations: ^{ [flashView setAlpha:1.0]; // 透明->白(0.4秒) }]; } else { [UIView animateWithDuration:0.4 animations: ^{ [flashView setAlpha:0.0]; // 白->透明(0.4秒) } completion:^(BOOL finished) { [flashView removeFromSuperview]; flashView=nil; }]; } }

今回は、UIViewアニメーション機能についてさらに詳しく解説しました。次回は、いよいよ明示的アニメーションの詳細に進みます。その先には、キーフレームアニメーションのようなCore Animationスペシャルな機能が待っています。 -

暗黙的アニメーションは忘れましょう!

この記事は、2012年04月26日に掲載されました。前回は、Core Animationの特徴となっている「暗黙的アニメーション」と「明白的アニメーション」の違いを解説しました。 今回は、CATransactionクラスとUIView自身のアニメーション機能についてお話したいと思います。

Core Animationで言う所の暗黙的(Implicit)と 明示的(Explicit)アニメーションですが、両方ともあまり一般的ではない表現です。これを、自動と手動アニメーションという表現に変えてやれば、もう少し分かりやすいかもしれません。引き続き、もう少し詳しく暗黙的アニメーションを見てみます。CALayerのプロパティの変更は、トランザクション(一括処理)としてCATransactionクラスにより管理されており、必要であればアニメーション化されます。つまり暗黙的アニメーションの方では、こうしたトランザクションがメインスレッドに作成され、実行ループの次の反復時に自動的に実行されるわけです。前回紹介した以下の処理は、

drt=myLayer.frame; drt.origin.x+=100; myLayer.frame=drt;実際には…

[CATransaction begin]; // トランザクション開始 drt=myLayer.frame; drt.origin.x+=100; myLayer.frame=drt; [CATransaction commit]; // トランザクション実行といった具合に処理されていることになります。

Core Animationにより、クラスメソッドのbeginとcommitが実行ループに自動的に挿入されているわけです。このように、プロパティの変更をbeginとcommitで挟んでアニメーションを実行させる方法を、明示的なトランザクションと呼ぶようです(挾まないのは暗黙的なトランザクション)。いよいよ分かりにくい話になってきましたが(笑)、こうしなくてもアニメーションは実行されるので、あまり利用すべき状況を思い浮かべられません。メインスレッドではない別スレッドからCALayerのプロパティを変更することでアニメーションを実行したければ、明示的トランザク ションを使う必要がありそうです。

CATransactionクラスには、トランザクションを制御するための便利なクラスメソッドがありますので、それらを活用することも可能です。例えば、アニメーションの1サイクルの時間はデフォルトで1.0秒でしたが、以下のどちらかのメソッドを利用すれば、その長さを任意の時間(例では3.0秒)とすることが可能です(後者が便利)。

[CATransaction setValue:[NSNumber numberWithFloat:3.0] forKey:kCATransactionAnimationDuration]; [CATransaction setAnimationDuration:3.0];また暗黙的なアニメーションを実行中に、CALAyerのプロパティ変更をアニメーションとして表示したくない場合には、以下のどちらかのクラスメソッドを、トランザクション処理の途中に入れてやります(後者が便利)。その後、setDisableActions:メソッドの引数にNOを渡せば、アニメーションの実行は再開されます。

[CATransaction setValue:(id)kCFBooleanTrue forKey:kCATransactionDisableActions]; [CATransaction setDisableActions:YES];暗黙的なトランザクションでは、すべてのアニメーションが実行ループのあるタイミングで一斉に再生されることになります。これをもう少し複雑に制御し、複数アニメーションをうまくネスティングさせたい時なども、明示的なトランザクションを利用することができます。最も外側のトランザクションがコミットされた場合のみ、それぞれのアニメーションか再生されます。簡単な例を上げると以下の様なソースコードとなります。ただし、これをiOSのメインスレッドで実行すると通常の暗黙的トランザクションとまったく同じ処理がなされます(beginとcommitは無視される)。

[CATransaction begin]; // 外側のトランザクション [CATransaction setAnimationDuration:3.0]; drt=myLayer.frame; drt.origin.x+=100; myLayer.frame=drt; [CATransaction begin]; // 内側のトランザクション drt=myView.frame; drt.origin.y+=100; myView.frame=drt; [CATransaction commit]; // 内側のトランザクション [CATransaction commit]; // 外側のトランザクションつまり、最初のX方向アニメションが終了するまで次のY方向アニメーションの実行を待機してくれるわけではないので、結局は同時にX,Y方向へ移動するアニメーションとなるわけです。複数の明示的アニメーションを強制的に同時実行したい時には、この方法ではなく、CAAnimationGroupクラス(CAAnimation.h)を使うと便利です。以下の例では、theAnimation1とtheAnimation2の両アニメーションを5.0秒のサイクルで同時に実行します。

gp=[CAAnimationGroup new]; // 先んじて2つのアニメーションは定義済み gp.duration=5.0; gp.animations=[NSArray arrayWithObjects:theAnimation1,theAnimation2,nil]; [theLayer addAnimation:gp forKey:nil];とりあえずCATransactionの解説をしてみましたが、OS Xの場合はともかく、iOSの場合には、ここまでの話しは忘れてもらってもかまいません(暗黙的アニメーションも含めて)。何故かというと、iOSのUIViewクラスにはCATransactionと類似したアニメーション機能が用意されているからです。こうした機能はOS Xで使うNSViewには用意されていないためiOS独自の機能なのですが、CATransactionよりこちらを活用した方が便利で簡単なのです。以下が、UIViewクラスのUIViewAnimationカテゴリーに定義されているアニメーション関連のクラスメソッドです。

・UIViewAnimationカテゴリー

+ (void)beginAnimations:(NSString *)animationID context:(void *)context; + (void)commitAnimations; // アニメーション定義開始と終了 + (void)setAnimationDelegate:(id)delegate; // 開始と終了時に呼ばれるデリゲート + (void)setAnimationWillStartSelector:(SEL)selector; // 開始時に呼ばれる処理セット // - (void)animationWillStart:(NSString *)animationID context:(void *)context + (void)setAnimationDidStopSelector:(SEL)selector; // 終了時に呼ばれる処理セット // - (void)animationDidStop:(NSString *)animationID finished: (NSNumber *)finished context:(void *)context + (void)setAnimationDuration:(NSTimeInterval)duration; // 1サイクルの時間 + (void)setAnimationDelay:(NSTimeInterval)delay; // 遅らせる時間 + (void)setAnimationStartDate:(NSDate *)startDate; // 開始日付 + (void)setAnimationCurve:(UIViewAnimationCurve)curve; // 時間軸制御のカーブ種類 + (void)setAnimationRepeatCount:(float)repeatCount; // 繰り返し回数 + (void)setAnimationRepeatAutoreverses:(BOOL)repeatAutoreverses; // 巻き戻しあり + (void)setAnimationBeginsFromCurrentState:(BOOL)fromCurrentState; // 4.0以前のみ + (void)setAnimationTransition:(UIViewAnimationTransition)transition forView:(UIView *)view cache:(BOOL)cache; // トランジション種類 typedef enum { // トランジションの種類 UIViewAnimationTransitionNone, UIViewAnimationTransitionFlipFromLeft, UIViewAnimationTransitionFlipFromRight, UIViewAnimationTransitionCurlUp, UIViewAnimationTransitionCurlDown, } UIViewAnimationTransition; + (void)setAnimationsEnabled:(BOOL)enabled; // アニメーション実行ON/OFF + (BOOL)areAnimationsEnabled; // アニメーシ実行ON/OFFの現在の状態今回は、CATransactionクラスの仕組みと、UIView自身のアニメーション機能が存在していることについてお話しました。次回は、UIViewアニメーション機能についてさらに詳しく解説いたします。

-

暗黙的と明白的アニメーション

この記事は、2012年04月13日に掲載されました。前回は、OS XとiOSにおけるCore Animetionを利用する場合の仕組みの違いなどを調べてみました。今回は、Core Animationの特徴となっている「暗黙的アニメーション」と「明白的アニメーション」の違いを簡単に解説したいと思います。

OS Xの場合、一度ビュー(NSView)にCALayerを割り当ててしまえば、Objective-Cのドット構文を使うことで、CALayerのプロパティを変更して暗黙的アニメーション(Implicit)を実行することが可能となります。つまり、特別にアニメーション設定を行わなくても、CALayerに対するプロパティの設定変更(表示位置の移動など)をCore Animationが自動でアニメ化してくれるわけです。例えば、以下の様なソースコードを記述すれば、レイヤ表示が右方向へ100ピクセル移動するアニメーションが実行されます。

- (IBAction)doImplicitAnimation:(id)sender // OS Xでの暗黙的アニメーション { CALayer *myLayer; CGRect drt; myLayer=[myView layer]; // NSViewからCALayerを得る drt=myLayer.frame; drt.origin.x+=100; // レイヤの表示位置を右へ移動する myLayer.frame=drt; }この時のアニメーションに有する時間(duration)はディフォルトとして1.0秒がセットされています。この値は実行時に変更することが可能です(次回解説の予定)。また、現バージョンのiOSで暗黙的アニメーションを行う場合には、CALayerのdelegateプロパティを設定しておくこと(nil以外のselfなど)が必要ですのでご注意ください。

delegateをセットする方法以外で暗黙的アニメーションが実行できないかと色々と試してみましたが、どうもダメでそうです。結局のところ、これが仕様かどうかは謎なのですが、iOSのUIViewについては暗黙的アニメーションを使わずとも別途アニメーション機能を備えていますので、そちらを使用した方が細かな制御が可能となります(こちらも次回解説の予定)。暗黙的アニメーションをソースコードで記述すると以下の様になります。

- (IBAction) doImplicitAnimation:(id)sender // iOSでの暗黙的アニメーション { CALayer *myLayer; CGRect drt; myLayer=myView.layer; myLayer.delegate=self; // これを設定しないと暗黙的アニメを行わない drt=myLayer.frame; drt.origin.x+=100; myLayer.frame=drt; }iOSではCALayerの代わりにUIViewのプロパティを操作することでも実行可能です。

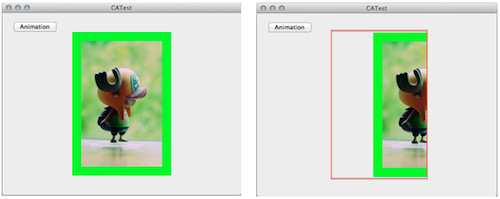

- (IBAction) doImplicitAnimation:(id)sender // UIViewのプロパティを変化させる { CALayer *myLayer; CGRect drt; myLayer=myView.layer; myLayer.delegate=self; // これを設定しないと暗黙的アニメをしない。 drt=myView.frame; drt.origin.x+=100; myView.frame=drt; // CALayerの代わりにUIViewのプロパティ変更でもOK }OS Xの場合には、以下の様にNSViewのエリア内しかアニメーションは表示されませんが、iOSでのアニメーションは、オリジナルのビュー矩形領域を外れていてもスクリーン内ならどこでも表示されます。iOSのUIWindowクラスはUIViewを継承していますが、OS XのNSWindowクラスはNSViewを継承していませんので、こうなるのだと思われます(多分)。

OS Xではウィンドウいっぱいの親ビューにレイアウトする必要あり

Core Animatinoには、ソースコードによる細かな設定でアニメーションを制御するための明白的アニメーション(Explicit)も用意されています。こちらでは、アニメーションの表示時間、繰り返し回数、移動パス、長さや速度変化を指示するカーブの種類などを設定することが可能です。個々のアニメーションはそれぞれが別スレッドとして実行されますので、その終了や開始はデリゲートメソッドで認識する仕組みとなっています。

以下は、CALayerの矩形サイズが縮小(縦横とも100ピクセル)される動きをアニメーション化したメソッドです。animationWithKeyPath:メソッドで渡している文字列(この例ではbounds)がアニメーション対象として指定するプロパティ名となります。 その後CABasicAnimationオブジェクトのfromValueプロパティに開始値(NSValue)を、toValueプロパティに終了値(NSValue)を代入してからアニメーションの対象とするCALayerオブジェクトに対しaddAnimation:forKey:メッセージを送ります。この場合forKey:に渡す引数はnilでもかまいません。

- (IBAction)doExplicitAnimation:(id)sender // OS Xの場合の明白的アニメーション { CABasicAnimation *anime; CALayer *layer; CGRect srt,drt; layer=[myNSView layer]; // NSViewから画像レイヤ(CALayer)を得る anime=[CABasicAnimation animationWithKeyPath:@"bounds"]; // アニメション作成 anime.repeatCount=5; // 拡大アニメを5回繰り返す anime.duration=2.0; // 1回のサイクルに2秒かける anime.autoreverses=YES; // 自動で逆向きに再生(リバース再生) srt=layer.bounds; // 開始矩形サイズ drt=CGRectInset( srt,50,50); // 終了矩形サイズ(縮小) anime.fromValue=[NSValue valueWithRect:NSRectFromCGRect( srt )]; anime.toValue=[NSValue valueWithRect:NSRectFromCGRect( drt )]; [layer addAnimation:anime forKey:@"boundsAnimation"]; // アニメションを実行 }- (IBAction)doExplicitAnimation:(id)sender // iOSの場合の明白的アニメーション { CABasicAnimation *anime; CALayer *layer; CGRect srt,drt; layer=myUIView.layer; // UIViewから画像レイヤ(CALayer)を得る anime=[CABasicAnimation animationWithKeyPath:@"bounds"]; // アニメション作成 anime.repeatCount=5; // 拡大アニメを5回繰り返す anime.duration=2.0; // 1回のサイクルに2秒かける anime.autoreverses=YES; // 自動で逆向きに再生(リバース再生) srt=layer.bounds; // 開始矩形サイズ drt=CGRectInset( srt,50,50); // 終了矩形サイズ(縮小) anime.fromValue=[NSValue valueWithCGRect:srt]; // iOSはvalueWithCGRectを使用可 anime.toValue=[NSValue valueWithCGRect:drt]; [layer addAnimation:anime forKey:@"boundsAnimation"]; // アニメション実行 }注意点は、fromValueとtoValueプロパティに渡す引数は構造体や数値そのものではなくて、それらをラップした「オブジェクト」だということです。上の例の場合、iOSでプロパティに渡すのはCGRect構造体ですが、OS XではNSRect構造体ですのでご注意ください。CGRect構造体はvalueWithCGRect:メソッドでNSValueオブジェクトにラップしてからプロパティに代入します。各構造体からNSValueへの変換メソッドは、ヘッダーファイルのUIGeometory.hやCATransform3D.hに定義されていますので参照してみてください。

今回は、Core Animationの特徴となっている「暗黙的アニメーション」と「明白的アニメーション」の違いを簡単に解説しました。次回は、CATransactionクラスとUIView自身のアニメーション機能についてお話したいと思います。

-

UIViewに割り当てられたCALayer

この記事は、2012年03月27日に掲載されました。前回は、Core Animationでアニメーションの対象となるCALayerのサブクラスの種類について解説しました。今回は、OS XとiOSにおけるCore Animetionを利用する場合の仕組みの違いなどを調べてみます。

まずはいつものことですが、Core Animationフレームワークに関する技術ドキュメントを入手し、それを読み込んでフレームワークの使い方を習得する必要があります。Core AnimationはiOSとOS Xで利用できますので、それぞれの技術リソースは、別々の「Developer Library」サイトから入手します。ただし、サンプルソースコード以外はほとんど共通です。最近では(Core Animationに限ったことではなく)両OSに共通の技術資料が多くなってきているのが、これからの未来を暗示しているようで興味深い傾向だと思います(笑)。

iOS Developer Libraryサイトに登録されているCore Animationに関するリソースは、そんなに多くはありません。また、登録されているサンプルソースコードもわずかです。ライブラリでの検索では「QuartzCore」と入力して絞り込みをしてください。現在、何故かサンプルソースコードの検索結果にQuartz Composer関連が含まれていますが、こちらのフレームワークは未だiOSではサポートされていません。Apple側の登録ミスだと思われますので、ご注意ください。 iOS版のCore Animationについては、以下の4つを参照することになります。フレームワークのリファレンス(クラスやメソッド)は「Core Animation Reference Collection」にまとめられています。

iOS関連サイト:http://developer.apple.com/library/ios/navigation/

「Core Animation Cookbook」(Core Animationを利用した簡単な例題 )

「Core Animation Programming Guide」(Core Animationの利用方法の基本)

「Animation Types and Timing Programming Guide」(種類やタイミング)

「Core Animation Reference Collection」(Core Animation APIリファレンス)iOSアプリでの使用方法は「Core Animation Programming Guide」を参照することになります。このドキュメントと「Animation Types and Timing Programming Guide」に関しては、以下のサイトに日本語訳版が登録されていますので、そちらを参照すべきでしょう。

和訳サイト:https://developer.apple.com/jp/devcenter/ios/library/japanese.html

「Core Animation プログラミングガイド」

「アニメーションのタイプとタイミング」iOSと比較して、Mac OS X Developer Libraryサイトに登録されている技術リソースは多岐にわたります。サンプルソースコードも沢山登録されていますので、実際にiOSで利用する前にいくつか試してみることをお奨めします。OS X版のCore Animationに関する技術ドキュメントについては、以下の2つが追加されています。

OS X関連サイト:http://developer.apple.com/library/mac/navigation/

「Animation Overview」(アニメーション技術一般とその実現方法の解説)

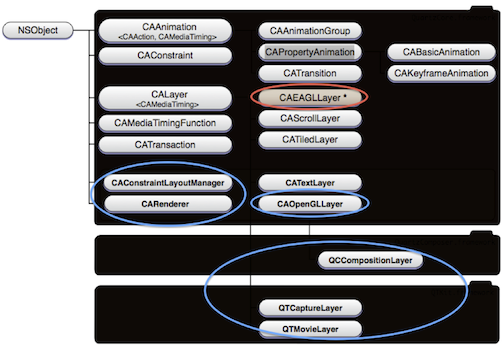

「Core Animation Overview」(Core Animation導入についての解説 )前回もお話しましたが、Core Animationのによるアニメーション処理は、NSViewやUIViewが所有するCALayerクラスやそのサブクラスを対象として実行されます。そして、実際にアニメーションをコントロールするのは、CAAnimationクラスとそのサブクラスです。以下が「Core Animation Programming Guide」ドキュメントに掲載されているCore Animationの各クラスの構成図です(少し内容が古いですが…)。

Core Animationのクラス構成図

赤丸で囲まれた「CAEAGLLayer」のみが、OpenGL ESで利用するために用意されているiOS独自のクラスです。青丸で囲まれた複数クラスは、OS X独自のクラスであり、iOSでは実装されていません。またこの構成図には記載がありませんが、現バージョンのiOSやOS Xでは、 前回取り上げたCALayerのサブクラスである「CAEmitterLayer」「CAGradientLayer」「CAShapeLayer」「CAReplicatorLayer」などが利用可能です。iOSでは、これらに加えて「AVPlayerLayer」や「CATransformLayer」なども追加されています。CALayerクラスはアニメーション表示をする画像や図形などのコンテンツ、表示状態、矩形枠などを保持しています。また親となるレイヤ上に複数の子レイヤを配置(レイアウト)することも可能です。そうした仕組み自体は、UIViewやNSViewと似ていますが、実はこのCALayerについてはiOSとOS Xではシステムによる実装形態が違い、iOSの方が後発のためかモダンな実装となっています。

UIKitのUIViewにはデフォルトでCALayerオブジェクトが割り当てられていますが、OS XのAppKitのNSViewでは割り当てられていません。そのため、OS Xではアニメーションを実行する前に、まずソースコードでCALayerオブジェクトを作成し、その後対象となるNSViewブジェクトへCALayerオブジェクトを渡す必要があります。

以下は、OS Xで背景用と画像用のCALayerを2つ作成しておいて、背景用のCALayerにもうひとつの画像用CALayerをレイアウトした後、対象となるNSViewにセットしているソースコード例です。

- (void)awakeFromNib // OS XでCALayerを作成する場合 { CALayer *imageLayer; CALayer *backLayer; NSBitmapImageRep *bitmap; CGImageRef image; CGColorRef color; backLayer=[CALayer layer]; // 背景用のレイヤ作成 imageLayer=[CALayer layer]; // 画像用のレイヤ作成 imageLayer.frame=CGRectInset( [myView bounds],20,20 ); // 画像表示枠 bitmap=[NSBitmapImageRep imageRepWithContentsOfFile: [[NSBundle mainBundle] pathForResource:@"Image" ofType:@"jpg"]]; image=[bitmap CGImage]; // JPEGファイルから画像の読み込み imageLayer.contents=(__bridge id)image; // コンテンツをセット(ARC用) color=CGColorCreateGenericRGB( 0.0,1.0,0.0,1.0 ); // 背景は緑色 backLayer.backgroundColor=color; CGColorRelease( color ); [backLayer addSublayer:imageLayer]; // 背景レイヤのサブレイヤにする [myView setLayer:backLayer]; // ビューにレイヤを設定 [myView setWantsLayer:YES]; // ビューのレイヤを有効にする }

上記と比較して、次のiOS用ソースコードでは、背景カラーについては、UIViewに用意されているCALayerオブジェクト(背景用)をlayerプロパティから得ることで設定しています。- (void)viewDidLoad // iOSでCALayerを作成する場合 { CALayer *imageLayer; CALayer *backLayer; UIImage *image; imageLayer=[CALayer layer]; // 画像用のレイヤ作成 imageLayer.frame=CGRectInset( myView.bounds,20,20 ); // 画像表示枠 image=[UIImage imageNamed:@"image.jpg"]; // JPEGファイルを読み込む imageLayer.contents=(id)image.CGImage; // コンテンツをセットする backLayer=myView.layer; // 背景用のレイヤはUIViewから得る backLayer.backgroundColor=[UIColor greenColor].CGColor; // 背景は緑色 [backLayer addSublayer:imageLayer]; // 背景レイヤのサブレイヤにする }

一度UIViewやNSViewにCALayerを割り当ててしまえば、Objective-Cのドット構文を使うことでCALayerの各種プロパティ値を変更できます。CALayerのプロパティとしては以下の様な種類が用意されています。frame、bounds、position、anchorPoint、anchorPointZ、cornerRadius、transform、zPosition、backgroundColor、backgroundFilters、contents、mask、contentsGravity、sublayers、masksToBounds、borderColor、opacity、sublayerTransform、borderWidth、filters、shadowColor、shadowOffset、shadowOpacity、shadowRadius、compositingFilter

今回は、OS XとiOSにおけるCore Animetionを利用する場合の仕組みの違いなどを調べてみました。次回は、Core Animationの特徴となっている「暗黙的アニメーション」と「明白的アニメーション」の違いを解説したいと思います。

-

CALayerのサブクラスを調べる

この記事は、2012年03月21日に掲載されました。前回は、 認識しておいた方が良いCore Imageに関する注意点について解説しました。今回からは、本格的にCore Animationフレームワークや、そこで利用されているCALayerクラスの話しに突入したいと思います。

Core Animationのによるアニメーション処理は、NSViewやUIViewが所有するCALayerクラスを対象として行われます。Apple社の説明では、CALayerはモデルクラスなのだそうですが、ちょっと戸惑うクラス分けです(笑)。AppKit(OS X)のNSViewでは、CALayerを新規作成して追加する必要がありますが、UIKit(iOS)のUIViewでは、それを作成した時点で、既にCALayerが割り当てられています。

CALayerには目的に応じて幾つものサブクラスが用意されており、それぞれに特化したコンテンツの表示や、Core Animationによる独自のアニメーションを実行することが可能となっています。今回は、こうしたCALayerのサブクラスの種類を確認してみたいと思います。CALayerのサブクラスの実装の状況はOS XとiOSで若干異なりますが、iOS 5では、以下のサブクラスを使用することができます。

● CAShapeLayer

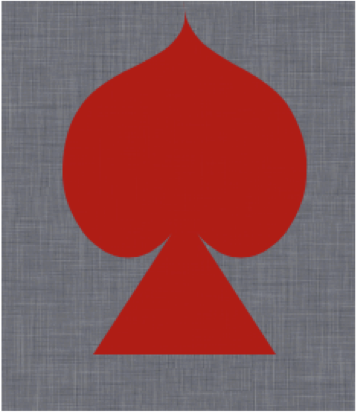

CAShapeLayerクラスは、Core Graphicsのパス図形を表示するよう特化したサブクラスです。パス図形を表示するためには、pathプロパティにCGPathRefを設定します。このレイヤにはパス図形に関する幾つかのプロパティを設定することができますが、その内容は、Core Graphics APIで設定できるパス図形の各種設定(幅、カラー、角処理、破線指定など)とほぼ一致しています。

CAShapeLayer サブクラス

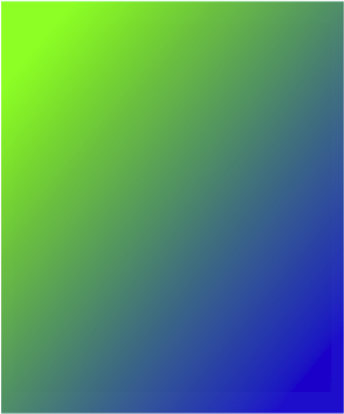

● CAGradientLayer

CAGradientLayerクラスは、レイヤの矩形領域内にグラデーションを描画する目的に特化したサブクラスです。どんなカラーからどんなカラーへとグラデーションを変化させて行くのかの情報は、colorsプロパティにCGColorRefの配列として保存しておきます。また、各色の変化の開始位置はlocationsプロパティにNSNumberとして保存します(指定しないと均等に展開)。グラデーションの開始位置と終了位置はstartPointとendPointプロパティに設定します。locatonsプロパティも含めて、どちらも(0.0~1.0)に正規化された座標値です。

CAGradientLayer サブクラス

●CAReplicatorLayer

CAReplicatorLayerクラスは、自分自身に配置したサブレイヤをコピーして繰り返し表示させる機能を持っています。繰り返しの個数はinstanceCountプロパティで設定し、同時に繰り返し表示するサブレイヤの座標値、カラーなどを徐々に変化させるためのプロパティが用意されています。instanceDelayプロパティは、サブレイヤ全体に対して何らかのアニメーションを実行する場合、展開されたレイヤに対しアニメションの開始時間を少しずつ遅らせるために設定します。 また、preservesDepthプロパティをYESにすることで2D画面を擬似的に3次元に展開した表示も可能となります。

CAReplicatorLayer サブクラス

● CATiledLayer

CATiledLayerクラスは大きく複雑な画像を段階的(複数タイルに分けて)に表示する場合に利用します。レイヤの表示時、このクラスを継承したサブクラスのdrawRect:メソッドはタイル数だけ呼ばれます。その時の描画コンテキスト(CGContextRef)の座標変換マトリックス(CGAffineTransform)のスケーリング要素(構造体メンバ)には、 levelsOfDetailプロパティとlevelsOfDetailBiasプロパティで指示したスケール値が入っていますので、それを参照し適切な画像データを選択する処理が可能となります。例えば、スケール値が大きければより高解像度の画像を用意しておく等です。

例えば、 levelsOfDetail=4とするとスケール値「CGContextGetCTM(context).a」が4段階で変化するよう指示したことになります。この場合、levelsOfDetailBias=0(バイスなし)であれば、スケール値は1.0、0.5、0.25、0.125の4段階変化します。また、levelsOfDetailBias=4(バイス4)であれば4段階大きい方へシフトして、スケール値は16、8、4、2の4段階変化します。小さい方へシフトする場合には、levelsOfDetailBiasにマイナスの値を代入します。

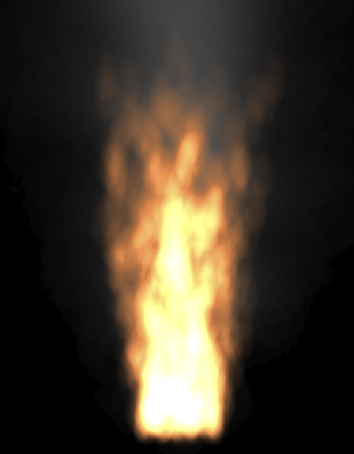

● CAEmitterLayer

CAEmitterLayerクラスは、小さなレンダリング画像パタンを多数集めてパーティクル(粒子)効果を表現するために利用するレイヤです。パーティクルで表現する現象の例としては、 炎、煙、雲、雨、花火など多数あります。CAEmitterLayerが多数のパーティクルをまとめて表示しますが、各パーティクルはCAEmitterCellクラスの方で定義し、そちらに用意されている多数のプロパティで、その特徴付けを行います。

CAEmitterLayer サブクラス

● CAScrollLayer

CAScrollLayerクラスは、レイヤの部分的な表示を簡素化するために用意されています。このクラスのサブクラスを作成し、用意されているスクロール用メソッドでレイヤのスクロールを行うと、drawRect:メソッドが呼ばれます。その中で、スクロールにより変化したvisibleRectプロパティ(CGRect)を参照して適切な部分描画を行います。ちなみに、このレイヤにはキーボード処理やマウスイベント処理、表示可能なスクロールバーなどのUI関連のメソッドは提供されていません。

● CATransformLayer

CATransformLayerクラスは、正確な3D座標で配置されたサブレイヤの階層を維持しており、これらの(Z=0)面への投影(描画)は行いません。また、通常の2D表示でサポートされるフィルタ処理などの幾つかの機能は働きません。このレイヤに特別なプロパティはありません。

● CAEAGLLayer

CAEAGLLayerクラスは、OpenGL ESの描画環境を提供します。OpenGL表示を行うためのビューを作成するには、以下の様にUIViewを継承した後layerClassクラスメソッドをオーバライドします。 このCALayerのサブクラスはOS Xには実装されていません。このサブクラスが定義されているヘッダファイルはOpenGLES.hです。

+ (Class) layerClass { return [CAEAGLLayer class]; }● AVPlayerLayer

AVPlayerLayerクラスは、映像(ムービー)再生の出力結果を表示するために用意されているサブレイヤです。こちらはAVFoundationフレームワークに属しており、映像再生のメソッドと一緒に利用されます。このサブクラスが定義されているヘッダファイルはAVPlayerLayer.hです。

残念ながら、こうしたCALayerのサブクラスを用いたApple社のiOS用サンプルソースコードはほとんどありません。しかし、OS X側にはCALayerサブクラスを用いたサンプルソースコードが多数用意さいれていますので、ぜひ一度試してみてください(以下参照)。

「Fire」CAEmitterLayerを利用した炎と煙のパーティクルアニメーション

「Fireworks」CAEmitterLayerを利用した花火のパーティクルアニメーション

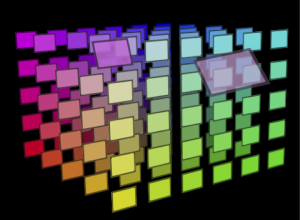

「ReplicatorDemo」CAReplicatorLayerを利用したカラーチャートアニメーション

「Gradients」CAGradientLayerを利用したグラデーション描画デモ

「CALayerEssentials」色々なサブレイヤのデモ(iOS実行不可もあるので注意)

「CocoaSlides」登録された画像ファイルでスライドショーを実行するデモ

「CoreAnimationKioskStyleMenu」CoreAnimationのキオスクモードでの利用

「CoreAnimationText」CAShapeLayerを利用したテキスト表示のデモ

「ImageTransition」CATransitionとCIFilterを使ったトランジションの実行

「LayerFlip」CALayerの表示を左右反転させるデモ

「NineSlice」画像の一部分を拡大表示するデモ今回はCore Animationでアニメーションの対象となるCALayerのサブクラスの種類について解説しました。次回は、OS XとiOSにおけるCore Animetionを利用する場合の仕組みの違いなどを調べてみます。

-

CIImage発、CGImageRef経由、UIImage行き

この記事は、2012年02月27日に掲載されました。前回は、 Lion(OS X 10.7)とiOS 5から追加されたCore Imageによる画質改善と顔認識機能を紹介しました。今回は、Core Animationフレームワークや、そこで利用されているCALayerクラスの話しに移りたいと思います。

と思っていましたが、その前にどうしても取り上げておいた方が良いCore Imageに関する注意点がありますので、今回は予定を変更してそれについて解説を致します。話の対象は、Core Animationのフィルタ処理の対象となる画像「CIImage」についてです。

Apple社が提供しているiOS版サンプルソースコードの中で、Core Imageに関するサンプルはたったひとつしかありません。それが「PocketCoreImage」です。このiOSアプリでは、UIViewのサブクラスであるFilteredImageViewクラスを用意し、そこにCore Imageによるフィルタ処理の結果(CIImage)を描画しています。描画処理を行っているFilteredImageViewクラスのdrawRect:メソッドは、以下の様に記載されています。

- (void)drawRect:(CGRect)rect // オーバライドされた描画用メソッド { [super drawRect:rect]; if( !_filteredImage ) return; CGRect innerBounds=CGRectMake( 5,5,self.bounds.size.width-10, self.bounds.size.height-10 ); [[UIImage imageWithCIImage:_filteredImage] drawInRect:innerBounds]; }

この処理内容内容を見ると、UIImageクラスにはimageWithCIImage:メソッド(iOS 5から利用可能)が用意されており、それによってCIImageをUIImageに変換可能なようです。このサンプルでも、そのメソッドを利用してdrawInRect:でフィルタ処理の結果(CIImage)を現在のビューの表示コンテキストに描画しています。これを見たプログラマーなら「CIImageからUIImageを作るのは簡単なのだから、いちいちFilteredImageViewクラスなど作成せずとも、変換結果をUIImageViewにセットすれば確認できるぞ!」思うはずです。つまり以下の様な記述をすればOKで、フィルタ処理の結果はUIImageViewですぐに確認できるはずです。

IBOutlet UIImageView *imageView; // 結果表示用UIImageビュー imageView.image=[UIImage imageWithCIImage:_filteredImage];

ところが、この処理を実行しても何故だかUIImageViewに画像は表示されません?以下の様に、一度CIImageをCGImageRef(Core Graphicsネイティブ画像)に変換した後に、されにUIImageに変換することで大丈夫となります。

CIImage *outputImage; // フィルタ処理後のCIImage画像 - (void)diplayImage // UIImageViewにフィルタ処理の結果を描画する { CGImageRef cgimage; CIContext *context; CGRect drt; drt=[outputImage extent]; // 画像フレーム(矩形枠) context=[CIContext contextWithOptions:nil]; // CIContext作成 cgimage=[context createCGImage:outputImage fromRect:drt]; // CGImageRefへ imageView.image=[UIImage imageWithCGImage:cgimage]; // UIImageへ CGImageRelease( cgimage ); }

この問題は、フィルタ処理をした画像を写真ライブラリに保存しようとした時にも発生します。普通に考えれば、UIImageWriteToSavedPhotosAlbum()ルーチンを使い以下の様に実行すればライブラリに保存されるはずです。

UIImageWriteToSavedPhotosAlbum( [UIImage imageWithCIImage:outputImage], self,@selector(image:didFinishSavingWithError:contextInfo:),nil );

ところが不思議なことに、これを実行するとエラーが生じて写真ライブラリへの保存に失敗します。やはりUIImageViewの場合と同様に、CIImageから一度CGImageRefを経由してUIImageを作成すると問題なく成功します。

CGImageRef cgimage; CIContext *context; UIImage *image; CGRect drt; drt=[outputImage extent]; // 画像フレーム(矩形枠) context=[CIContext contextWithOptions:nil]; // CIContext作成 cgimage=[context createCGImage:outputImage fromRect:drt]; // CGImageRefを作成 image=[UIImage imageWithCGImage:cgimage]; // CGImageRefからUIImageを作成 if( image ) UIImageWriteToSavedPhotosAlbum( image,self, @selector(image:didFinishSavingWithError:contextInfo:),nil);

ちなみに、UIGraphicsBeginImageContext()とUIGraphicsEndImageContext()を利用した別手段もあります。オフスクリーンコンテキストで新規UIImageを作成しています。

UIImage *image; CGRect drt; drt=[outputImage extent]; // 画像フレーム(矩形枠) UIGraphicsBeginImageContext( drt.size ); // オフスクリーンContext作成 [[UIImage imageWithCIImage:outputImage] drawInRect:drt]; // 画像の描画 image=UIGraphicsGetImageFromCurrentImageContext(); // 新規にUIImage作成 UIGraphicsEndImageContext(); if( image ) UIImageWriteToSavedPhotosAlbum( image,self, @selector(image:didFinishSavingWithError:contextInfo:),nil);

ただし、既にUIUmageに変換してUIImageViewへセットしてあるとすれば、以下の処理のみでOKです。こうなれば簡単ですね。

if( imageView.image ) UIImageWriteToSavedPhotosAlbum( imageView.image,self, @selector(image:didFinishSavingWithError:contextInfo:),nil);

iOSが4.0以上なら、ALAssetsLibraryクラスを利用してCGImageRefをそのまま写真ライブラリへ保存する手もあります。こちらは、画像のファイル保存がバックグランドで処理されますので、対象デバイスがiOS 4.0以上であれば一番推奨される一手でしょう。処理に使用されるメモリ容量も、この方法が一番少ないかもしれません(多分)。

CIContext *context; ALAssetsLibrary *library; CGImageRef cgimage; CGRect drt; drt=[outputImage extent]; // 画像フレーム(矩形枠) context=[CIContext contextWithOptions:nil]; // CIContext作成 cgimage=[context createCGImage:outputImage fromRect:drt]; // CGImageRefを作成 library=[ALAssetsLibrary new]; // アセットライブラリ作成 [library writeImageToSavedPhotosAlbum:cgimage metadata:[outputImage properties] completionBlock:^(NSURL *assetURL, NSError *error) // 終了時のブロック処理 { CGImageRelease(cgimage); }];

詳しくは調べていませんが、どうもdrawInRect:のみ(描画系メソッドのみ?)CIImageからダイレクト変換したUIImageに対応している雰囲気で、それ以外の処理はCGImageRefを経由したUIImageでないと対処できないようです。CIImageはOpenGL ESのテクスチャ形式の画像(GPU経由アクセスのビデオメモリ)だと思われますので、その辺りでUIKitからの操作に色々と制限が付いているのかもしれません。これがバグなのか?仕様なのか?判断はできませんが(多分仕様)、iOSのバージョンアップにより改善されることをの望みたいと思います。今回は予定を変更し、取り上げておいた方が良いCore Imageに関する注意点について解説しました。次回からは、本当にCore Animationフレームワークや、そこで利用されているCALayerクラスの話しに突入したいと思います。

-

こんな機能もあったのか!

この記事は、2012年02月16日に掲載されました。前回は、iOS 5版のCore Imageについての注意点について解説しました。今回は、Core Imageの最新機能を取り上げ、そこからCALayerやCore Animationへと話題を広げて行きたいと思います。

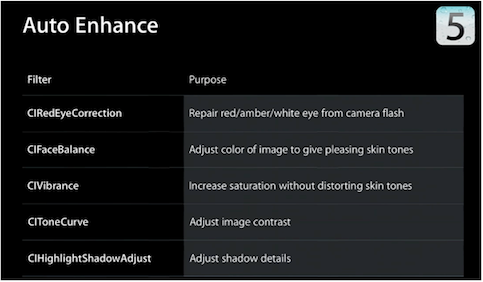

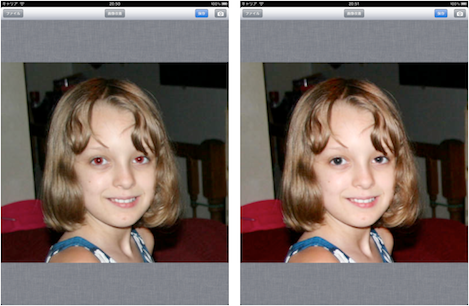

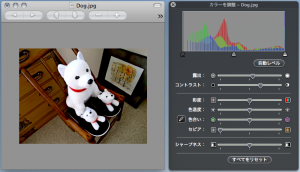

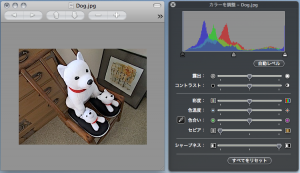

今回は、 Lion(OS X 10.7)とiOS 5から追加された「画質改善」と「顔認識」機能を紹介します。Apple社のスペシャルイベントなどで紹介されていたこの機能、いったどこに存在するのか疑問だったのですが、何とCore Imageに実装されていたわけです。最初の「画質改善」は、特定のフィルタで処理を行うのではなく、入力画像をCore Imageに解析させて、より見栄えのよい結果へと自動で画質を改善(エンハンス)させます。例えば、露出不足やコントラスト不足や肌色の彩度異常などを自動で修正します。加えて、特別な機能として「赤目」画像を修正することもできます。WWDC2001のセッションによると、このエンハンス処理に利用されるフィルタは以下の5種類だそうです。

何故だか単独では使えないフィルタもある?

この中のCIRecEyeCorrectionとCIFceBalanceは単独フィルタとしてはカテゴリに登録されておらず、リファレンスにも使用方法の掲載がありません(謎)。 画質改善機能を利用するのには、CIImageクラスに定義されている以下のどちらかのメソッドを使います。

- (NSArray *)autoAdjustmentFilters - (NSArray *)autoAdjustmentFiltersWithOptions:(NSDictionary *)dict以下が、自動で入力画像の画質改善を実行するメソッドです。非常に簡単に処理を実装できることが分かります。

- (CIImage *)doEnhance:(CIImage*)inputimage // 画質改善処理 { CIImage *image; NSArray *array; if( image=inputimage ) { // 自動エンハンス処理 array=[image autoAdjustmentFiltersWithOptions:nil]; for( CIFilter *filter in array ) // 配列個数分ループ { // 対象フィルタに順次入力画像を渡す [filter setValue:image forKey:@"inputImage"]; image=filter.outputImage; } } return image; // 結果画像を返す }

赤目が修正されているだけではなく肌の色も改善!

autoAdjustmentFiltersWithOptions:メソッドには、NSDictionary経由でオプションを指示できます。オプション無しはnilを代入すればOKです。 例えば、赤目処理だけを実行したい場合には、kCIImageAutoAdjustEnhanceキーにfalse値を、赤目以外の処理だけを実行したい場合には、kCIImageAutoAdjustRedEyeキーにfalse値を代入して渡します。

続いて「顔認識」の紹介です。この機能を利用するのもとても簡単です。 まずは、オプション(NSDictonary)を設定し、以下のクラスメソッドでCIDetectorクラスのインスタンスを作成しておきます。

- (CIDetector *)detectorOfType:(NSString*)type context:(CIContext *)context options:(NSDictionary *)options - (void)viewDidLoad // CIDetectorインスタンスを作成しておく { NSDictionary *options; [super viewDidLoad]; // オプション値はCIDetectorAccuracyHighでキーはCIDetectorAccuracy options=[[NSDictionary alloc] initWithObjectsAndKeys: CIDetectorAccuracyHigh,CIDetectorAccuracy,nil]; faceDetector=[[CIDetector detectorOfType:CIDetectorTypeFace context:nil options:options]retain]; // CIDetectorインスタンス作成 }オプションでは、CIDetectorAccuracyキーにより認識率を優先するのか?処理速度を優先するのか?を選択できます。例えばCIDetectorAccuracyHigh値を代入しておけば、認識率を上げることを優先して処理が行われます。ちなみに、現バージョンがサポートしている顔認識のタイプはCIDetectorTypeFace(人間の顔)だけとなります(笑)。

顔認識の実行は、以下のメソッドで行います。結果はCIFeatureオブジェクトの配列で返されます。つまり、写真に写っているのは複数人でもOKということになります(人数に限界があるかどうかは未確認)。この時に渡すオプションは画像の回転情報です。

- (NSArray *)featuresInImage:(CIImage *)image options:(NSDictionary *)optionsCIFeatureクラスには、顔枠(フレーム)を示すboundsプロパティ(CGRect)や、両目の位置を示すleftEyePositionとrightEyePositionプロパティ(CGPoint)、そして口の位置を示すmouthPositionプロパティ(CGPoint)が保存されます。顔認識が成功したら、これらのプロパティを参照して各エリアに対して適切な処理を行います。

以下のdoFaceDitectメソッドでは、インスタンス変数として用意しておいたUIImageViewのimageViewに画像を保存しておき、顔認識を実行後に顔フレームや両目、口の位置に図形を描いてからUIImageに変換してimageViewに保存し直しています。

- (void)doFaceDitect // 顔認識処理を実行して各ポイントを描画する { NSArray *features; CIImage *cimage; CGRect drt,prt; CGSize size; CGContextRef ctx; CGPoint pt; // UIImageからCIImgaeを作る if( cimage=[[CIImage alloc] initWithCGImage:imageView.image.CGImage options:nil] ) { features=[faceDetector featuresInImage:cimage options:nil]; // 顔認識を実行 [cimage release]; if( features ) { size=imageView.image.size; UIGraphicsBeginImageContext( size ); // UIImage作成開始 ctx=UIGraphicsGetCurrentContext(); CGContextTranslateCTM( ctx,0.0,size.height ); CGContextScaleCTM( ctx,1.0,-1.0 ); // 座標を上下ひっくり返す drt=CGRectMake( 0,0,size.width,size.height ); // 描画フレーム CGContextDrawImage( ctx,drt,imageView.image.CGImage); // CGImage描画 CGContextSetLineWidth( ctx,3.0 ); // ライン幅設定 for( CIFaceFeature *ff in features ) // 認識顔の個数分ループ { // 顔枠の表示色は赤 目の表示色は青 口の表示色は緑とする CGContextSetStrokeColorWithColor( ctx,[UIColor redColor].CGColor ); CGContextStrokeRect( ctx,ff.bounds ); // 顔認識の矩形枠を描画 CGContextSetStrokeColorWithColor( ctx,[UIColor blueColor].CGColor ); if( ff.hasLeftEyePosition ) // 左目位置が認識されているか? { pt=ff.leftEyePosition; prt=CGRectMake( pt.x-4,pt.y-4,8,8 ); CGContextStrokeEllipseInRect( ctx,prt ); // 右目に円を描画 } if( ff.hasRightEyePosition ) // 右目位置が認識されているか? { pt=ff.rightEyePosition; prt=CGRectMake( pt.x-4,pt.y-4,8,8 ); CGContextStrokeEllipseInRect( ctx,prt ); // 左目に円を描画 } CGContextSetStrokeColorWithColor( ctx,[UIColor greenColor].CGColor); if( ff.hasMouthPosition ) // 口の位置が認識されているか? { pt=ff.mouthPosition; prt=CGRectMake( pt.x-4,pt.y-4,8,8 ); CGContextStrokeEllipseInRect( ctx,prt ); // 口に円を描画 } } // 作成されたUIImage画像をUIImageViewへ登録 imageView.image=UIGraphicsGetImageFromCurrentImageContext(); UIGraphicsEndImageContext(); // UIImage作成終了 } } }

何人まで認識できるかは調べていません

写真の顔は少し傾いていたり横を向いていたりしても認識されますが、写真の方向には注意してください(90度回転など)。写真自体の方向が正しくないと、顔が正面を向いていても認識はされませんのでご注意ください。

今回は、 Lion(OS X 10.7)とiOS 5から追加されたCore Imageによる画質改善と顔認識機能を紹介しました。次回からは、Core Animationフレームワークや、そこで利用されているCALayerクラスの話しに移りたいと思います。

-

もっとビルトイン・フィルタを!

この記事は、2012年01月30日に掲載されました。前回は、 Xcode 4での開発途中でプロジェクト名やアプリ名を変更する操作について解説しました。 今回は、iOS 5の登場でiOSアプリ上で利用可能になった「Core Image」の話しに戻りたいと思います。

iOS 5で実装されたCore Imageの機能についても、OS Xの場合と同様に「Developer Library」サイトに登録されている以下のドキュメントで確認することができます。残念ながら、日本語に訳されているドキュメントはありません。

Developer Libraryサイト:http://developer.apple.com/library/ios/navigation/

「Core Image Programming Guide」(Core Imageプログラミングの詳細な解説)

「Core Image Filter Reference」(Core Image搭載のフィルタのリファレンス)

「Core Image Reference Collection」(Core Imageの全APIのリファレンス)注意すべきは、iOS版の「Core Image Programming Guide」の最初の方には次のような記載があることです。どうも、このドキュメントはOS X用の資料の転用であり、完全にiOS 5に対応させた形で書かれてはいないようです。つまり、ここに書かれていることがすべてiOS側で実現できるかどうかは定かではないということです。

早くちゃんとしたガイドを出して欲しいところ

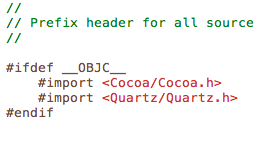

iOS版のCore Imageについて認識しておく点は、iOS版はOS X版のサブセットだと言うことです。例えば、OS Xの場合には「Built-in Filters」として、開発者の独自フィルタ・モジュール(以前に解説したImage Unit)をプラグインとして提供できますが、その機能は iOSではサポートされていません。基本的に、どんな機能が省略されているかについては、ヘッダファイルのCoreImeg.hを見ると理解できます。このヘッダファイルには、Core Imageで使える機能をクラス別に分けたヘッダファイルとして定義されています。 以下がその内容です。

#import <Foundation/Foundation.h> #import <CoreImage/CIColor.h> #import <CoreImage/CIContext.h> #import <CoreImage/CIFilter.h> #if !TARGET_OS_IPHONE #import <CoreImage/CIFilterGenerator.h> // iOSでは使用不可 #import <CoreImage/CIFilterShape.h> // iOSでは使用不可 #endif #import <CoreImage/CIImage.h> #if !TARGET_OS_IPHONE #import <CoreImage/CIImageAccumulator.h> // iOSでは使用不可 #import <CoreImage/CIImageProvider.h> // iOSでは使用不可 #import <CoreImage/CIKernel.h> // iOSでは使用不可 #import <CoreImage/CIPlugIn.h> // iOSでは使用不可 #import <CoreImage/CIRAWFilter.h> // iOSでは使用不可 #import <CoreImage/CISampler.h> // iOSでは使用不可 #endif #import <CoreImage/CIVector.h> #import <CoreImage/CIDetector.h> #import <CoreImage/CIFeature.h>ここで「#if !TARGET_OS_IPHONE」によりiOS環境で除外されている定義が、iOSでは利用できないクラスやメソッドです。例えば、先ほど紹介したフィルタプラグインに関係するクラスやメソッドは、CIPlugin.hやCIKernel.hなどに定義されていますので、そうした機能はiOSでは利用できないことが理解できます。

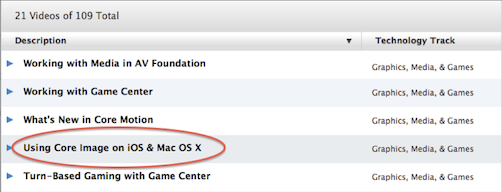

もうひとつ参考にしたい資料は「WWDC 2011セッションビデオ」です。ここでの話の内容はプレビュー版iOS 5が対象なのですが、非常に分かりやすい解説とデモ(いくらかのソースコード)が紹介されていますので、Apple社とデベロッパー契約を結んでいる方は、ぜひ一度視聴されることをお勧めします。セッション名は「Using Core Image on iOS & Mac OS X」です。

WWDC2011サイト:http://developer.apple.com/videos/wwdc/2011/index.php

Core Image関連のセッションはひとつだけ

サイトのタイトルの一番左側の三角をクリックすると、そのセッションの簡単な説明が表示され、Web経由やiTunes経由でのビデオ映像の視聴が可能です。ただし、セッションは1時間近い長さなので、先んじてセッションのスライド資料(PDF)をダウンロードして目を通しておくのが良いでしょう。

スライドPDFを参考にすると認識が深まる

このセッションを見ると分かるのですが、OS X版とiOS版のCore Imageにおける最大の差異は、用意されているビルトイン・フィルタの数が異なることです。 OS Xには150以上ものフィルタが用意されていますが、WWDC2011のセッションでは「ビルトインフィルタは16」と紹介されています(威張ることでは無い…)。ただし、iOS 5の正式版ではその数が48に増えているようです。 とは言っても、筆者が直ちに利用してみたいと考えていたトランジション系のフィルタや、ぼかしやシャープネスといった利用頻度の高いフィルタが用意されていません(涙)。

そこで、利用可能なフィルタの種類を確認したいわけですが、ドキュメントの「Core Image Filter Reference」もプレビュー版のiOS 5が対象なようでして、正確な種類が把握できません。ヘッダファイル(CIFilter.h)に一覧でも記載されていれば良いのですが、どうもそれも無いようで、以下のCIFilterクラスのクラスメソッドを使い、自分で入手するのが近道です。

+ (NSArray *)filterNamesInCategory:(NSString *)category; + (NSArray *)filterNamesInCategories:(NSArray *)categories;そこで、カテゴリに属するフィルタをすべて列挙するサンプルアプリ「FileType」を作成してみました。このアプリを使えば、将来的にiOS 5.1や5.2(もしくは6.0)が登場した時に、利用可能なフィルタが増えているかどうかを簡単に確認できます。サンプル「FilterType」のXcode 4プロジェクトは、以下のサイトからダウンロード可能です。

サンプルアプリ:http://www.ottimo.co.jp/library/iPad/FilterType.zip

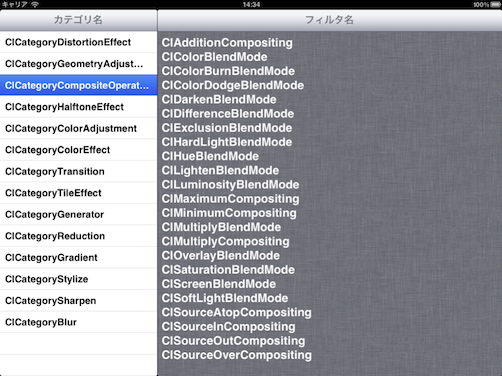

各カテゴリに属するフィルタ名を表示する

Core Imageのフィルタはその用途によりカテゴリごとにまとめられています。 CIFilterクラスのfilterNamesInCategory:メソッドは、カテゴリ名を指示することで特定のカテゴリに属するフィルタ名(NSString)を配列(NSArray)として返します。また、 filterNamesInCategories:メソッドでは、配列(NSArray)で複数のカテゴリを指定できます。また、こちらの引数にnilを渡すことで、利用できるすべてのフィルタ名を得ることも可能です。

現在、CIFilter.hに定義されている機能別カテゴリは全部で14あります。 残念ながら実装されている全カテゴリ名を返すクラスメソッドはありませんので、このサンプルではMasterlViewController.mにおいて、すべてのカテゴリ名を手動で配列に加えてアクセスできるようにしています。

- (void)viewDidLoad { [super viewDidLoad]; categolies=[[NSMutableArray array] retain]; // 14カテゴリ名を配列に登録 [categolies addObject:kCICategoryDistortionEffect]; [categolies addObject:kCICategoryGeometryAdjustment]; [categolies addObject:kCICategoryCompositeOperation]; [categolies addObject:kCICategoryHalftoneEffect]; [categolies addObject:kCICategoryColorAdjustment]; [categolies addObject:kCICategoryColorEffect]; [categolies addObject:kCICategoryTransition]; [categolies addObject:kCICategoryTileEffect]; [categolies addObject:kCICategoryGenerator]; [categolies addObject:kCICategoryReduction]; [categolies addObject:kCICategoryGradient]; [categolies addObject:kCICategoryStylize]; [categolies addObject:kCICategorySharpen]; [categolies addObject:kCICategoryBlur]; // 最初のカテゴリに属するフィルタ名を表示する [self.tableView selectRowAtIndexPath:[NSIndexPath indexPathForRow:0 inSection:0] animated:NO scrollPosition:UITableViewScrollPositionMiddle]; }サンプルのカテゴリ一覧をタップするとDetailViewController.mのshowFilterType:メソッドが呼ばれます。そのカテゴリに属するフィルタ名をUITextViewに表示するのには、 filterNamesInCategory:クラスメソッドを利用しています。

-(void)showFilterType:(NSString *)categoly { NSArray *array; NSString *str=@""; array=[CIFilter filterNamesInCategory:categoly]; // フィルタ名の配列を得る for( NSString *str1 in array ) str=[str stringByAppendingFormat:@"%@\n",str1]; // 表示文字列に追加 textView.text=str; // テキストビューに表示する }今回は、iOS 5版のCore Imageについての注意点について解説しました。次回は、Core Imageの最新機能を取り上げ、そこからCALayerやCore Animationへと話題を広げて行きたいと思います。

-

くっきり、すっきり、名称変更!

この記事は、2012年01月12日に掲載されました。前回は、 ローカライズ用リソースファイルをプロジェクトに登録する時の注意点を取り上げました。今回は、Xcode 4での開発途中でプロジェクト名やアプリ名を変更する操作について解説したいと思います。

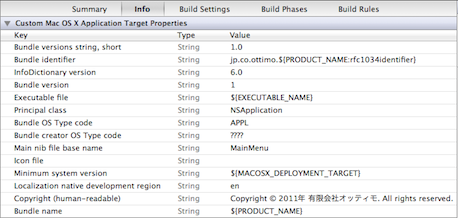

Xcode 4の雛形(テンプレート)から新規プロジェクトを作成した後に、アプリ名を変更したい場合が多々あります。例えば、最初の名称が気にくわなくなったとか、調べたら既にその名称はApp Storeで使われていたとかです。そればかりではなく、以前に作成したプロジェクトを転用するために、フォルダごとコピーしてからプロジェクト名やアプリ名を変更して編集を継続したい場合もあります。Xcode 3.2までは、プロジェクトメニューの項目に「名称変更…」があり、それを選択すれば簡単でしたが、Xcode 4では、そのメニュー項目が消えてしまっています。

「どうしたものか?」と調べてみたところ、デベロッパーからはこの件に対する疑問が多いようですね(笑)Apple社が提供している以下の「Technical Q&A」に回答がありました。

Technical Q&A QA1625「How do I rename my application in Xcode?」

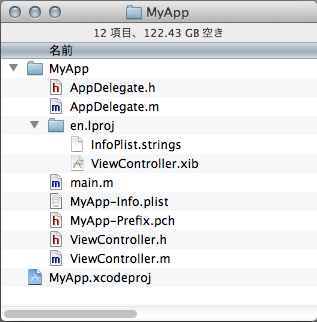

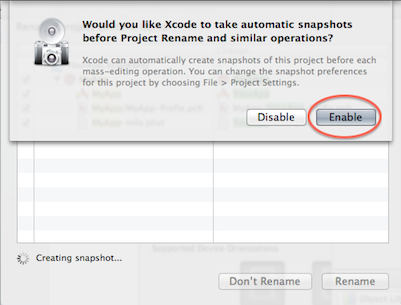

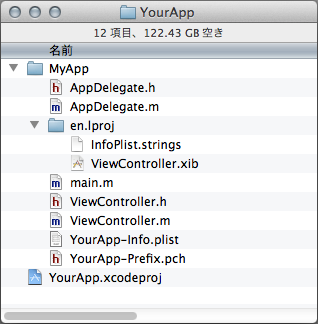

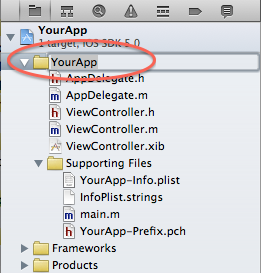

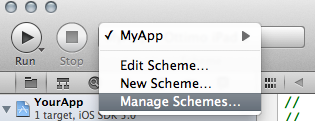

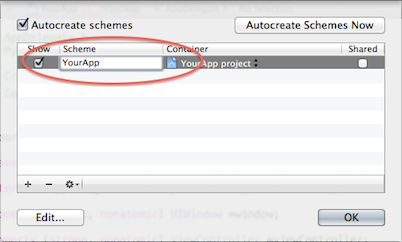

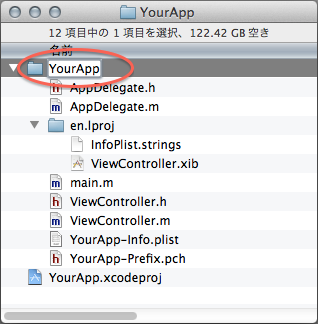

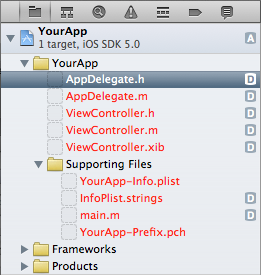

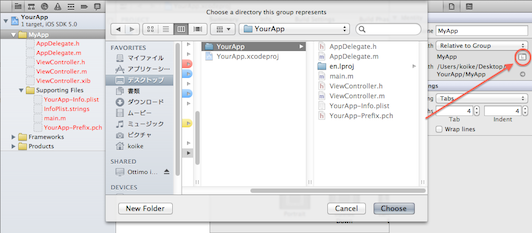

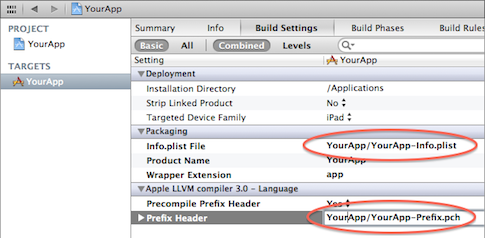

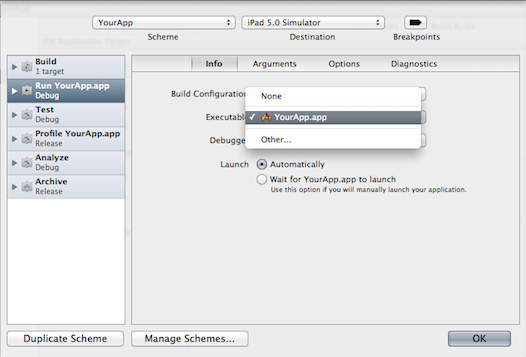

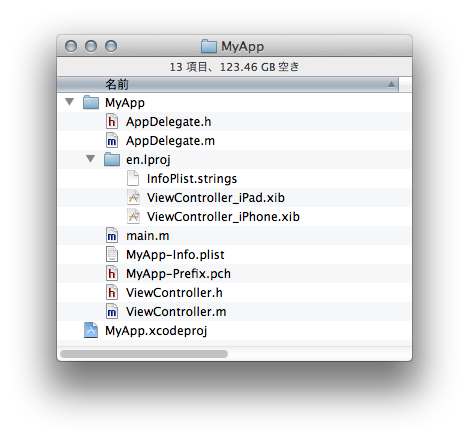

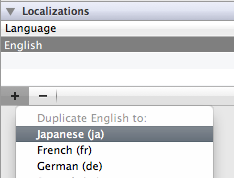

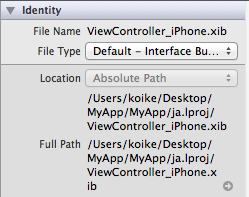

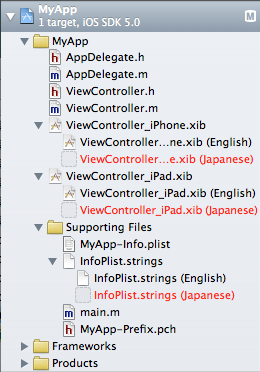

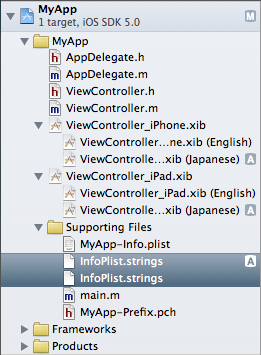

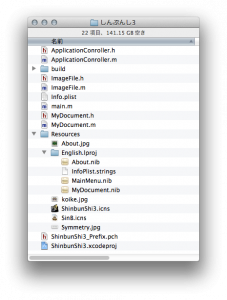

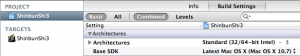

例えば、テンプレートから作成した「MyApp」のプロジェクト名(アプリ名も同じ)を「YourApp」に変更してみます。このプロジェクト、最初の時点では以下のようなフォルダ内容となっています。

名称変更前のプロジェクトフォルダの内容

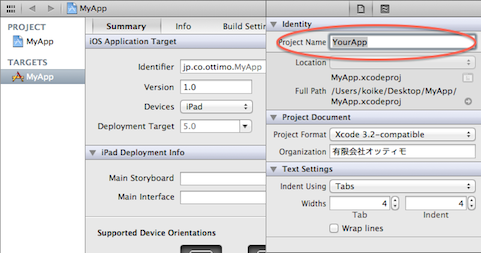

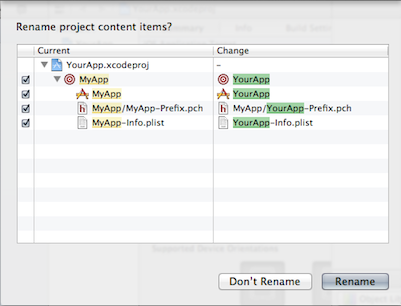

まずは、Finderでプロジェクトのフォルダ名を「YourApp」に変更します。この作業は、Xcode 4でプロジェクトをオープンしていない状態で行ってください。でないとXcodeからエラー表示がなされます。続いて「TARGET」を選択して、右側の「File Inspector」で表示されている「Project Name」を「YourApp」に変更します。